Agent State Machine:大语言模型管理的革新框架

- King

- 发布于 2025-02-09 17:53

- 阅读 3239

在人工智能飞速发展的当下,大语言模型(LLM)的应用愈发广泛。但如何有效管理LLM代理,确保其行为的可预测性、可维护性和可扩展性,成为了亟待解决的问题。今天,我们就来探讨一种创新的解决方案——AgentStateMachine。什么是AgentStateMachineAg

在人工智能飞速发展的当下,大语言模型(LLM)的应用愈发广泛。但如何有效管理 LLM 代理,确保其行为的可预测性、可维护性和可扩展性,成为了亟待解决的问题。

今天,我们就来探讨一种创新的解决方案 —— Agent State Machine。

什么是 Agent State Machine

Agent State Machine 是一种运用状态机模式管理大语言模型(LLM)代理的实验性框架。

它为构建可预测、可维护和可扩展的 AI 代理提供了强大且可扩展的基础。

为何要在 LLM 代理中使用状态机

可预测和可控的行为

确定性的状态转换确保了代理行为的一致性和可预测性;预定义的工作流程引导代理完成复杂任务,减少意外行为;结构化的错误状态则能在不影响整个系统的情况下实现优雅恢复。

增强调试和监控

可观察的状态能实时跟踪和记录每个状态转换,便于进行历史分析;状态历史跟踪有助于诊断问题和优化性能;清晰的入口和出口点则简化了在特定状态内的调试工作。

模块化和可维护的代码

每个状态封装了特定功能,实现了关注点分离,使代码库模块化;易于扩展,可在不全面修改系统的情况下添加或修改状态和转换;还能独立测试状态和转换,确保可靠性。

异步和并发处理

非阻塞操作可处理长时间运行的任务,而不阻塞主执行线程;消息队列处理可顺序或并发处理消息,提高吞吐量;资源优化则能高效管理 API 调用、网络连接和内存等资源。

对代理行为的细粒度控制:

可定制的状态逻辑能通过定义自定义状态和转换来调整代理行为;事件驱动的响应能在状态框架内动态响应外部事件或用户输入;还能实现复杂行为,如重试、超时和条件分支。

功能特性

-

灵活的状态管理:可为 LLM 代理定义和管理自定义状态。

-

内置聊天历史跟踪:轻松维护对话历史。

-

状态变更通知:订阅状态变更以进行实时监控。

-

强大的错误处理:通过清晰的恢复路径优雅处理错误。

-

工具集成:无缝集成工具和 API(如 arXiv API)。

-

异步处理:高效处理长时间运行或排队的任务。

-

与 Rig 兼容:可与任何 Rig 兼容的 LLM 提供商配合使用。

安装与快速上手

安装

克隆git仓库并进入到 agent_state_machine 目录:

git clone https://github.com/0xPlaygrounds/rig-examples.git

cd rig-examples/agent_state_machine快速上手:

代码示例展示了如何初始化 OpenAI 客户端、创建代理、状态机,以及处理消息和监控状态变化。

use agent_state_machine::{ChatAgentStateMachine, AgentState};

use rig::providers::openai;

#[tokio::main]

async fn main() {

// Initialize OpenAI client

let client = openai::Client::from_env();

// Create agent with GPT-4

let agent = client

.agent(openai::GPT_4)

.preamble("You are a helpful AI assistant.")

.build();

// Create state machine

let mut state_machine = ChatAgentStateMachine::new(agent);

// Subscribe to state changes

let mut state_rx = state_machine.subscribe_to_state_changes();

// Monitor state changes

tokio::spawn(async move {

while let Ok(state) = state_rx.recv().await {

println!("📍 State changed to: {}", state);

}

});

// Set up a response callback

state_machine.set_response_callback(|response| {

println!("🤖 Assistant: {}", response);

});

// Process a message

state_machine

.process_message("Hello!")

.await

.unwrap();

// Wait until processing is complete

while state_machine.current_state() != &AgentState::Ready {

tokio::time::sleep(std::time::Duration::from_millis(100)).await;

}

}代码流程说明

- 引入依赖:代码开头通过use语句引入agent_state_machine库中的ChatAgentStateMachine和AgentState,以及rig::providers::openai,为后续使用相关功能做准备。

- 初始化 OpenAI 客户端:在main函数中,首先通过openai::Client::from_env()从环境变量获取配置信息,初始化 OpenAI 客户端,用于与 OpenAI 服务通信。

- 创建代理:使用已初始化的 OpenAI 客户端创建一个代理,指定使用 GPT-4 模型,并设置开场白,这个代理将负责与用户进行交互。

- 实例化聊天代理状态机:利用创建好的代理实例化ChatAgentStateMachine,用于管理代理的状态和行为。

- 订阅状态变化:调用subscribe_to_state_changes方法订阅状态机的状态变化,获取一个Receiver对象,用于接收状态变化通知。

- 监控状态变化:通过tokio::spawn启动一个新的异步任务,在这个任务中循环接收状态变化通知,并打印出状态变化信息,实现对状态机状态的实时监控。

- 设置响应回调函数:使用set_response_callback方法设置一个回调函数,当代理处理完消息得到响应时,该回调函数会被调用,用于打印代理的回复内容。

- 处理消息:调用process_message方法让状态机处理消息 "Hello!",并等待处理完成。如果处理过程中出现错误,unwrap会使程序直接终止。

- 等待处理完成:通过循环检查状态机的当前状态,直到状态变为AgentState::Ready,表示代理已处理完消息并准备好接收新输入,确保程序在代理完成任务前不会结束 。

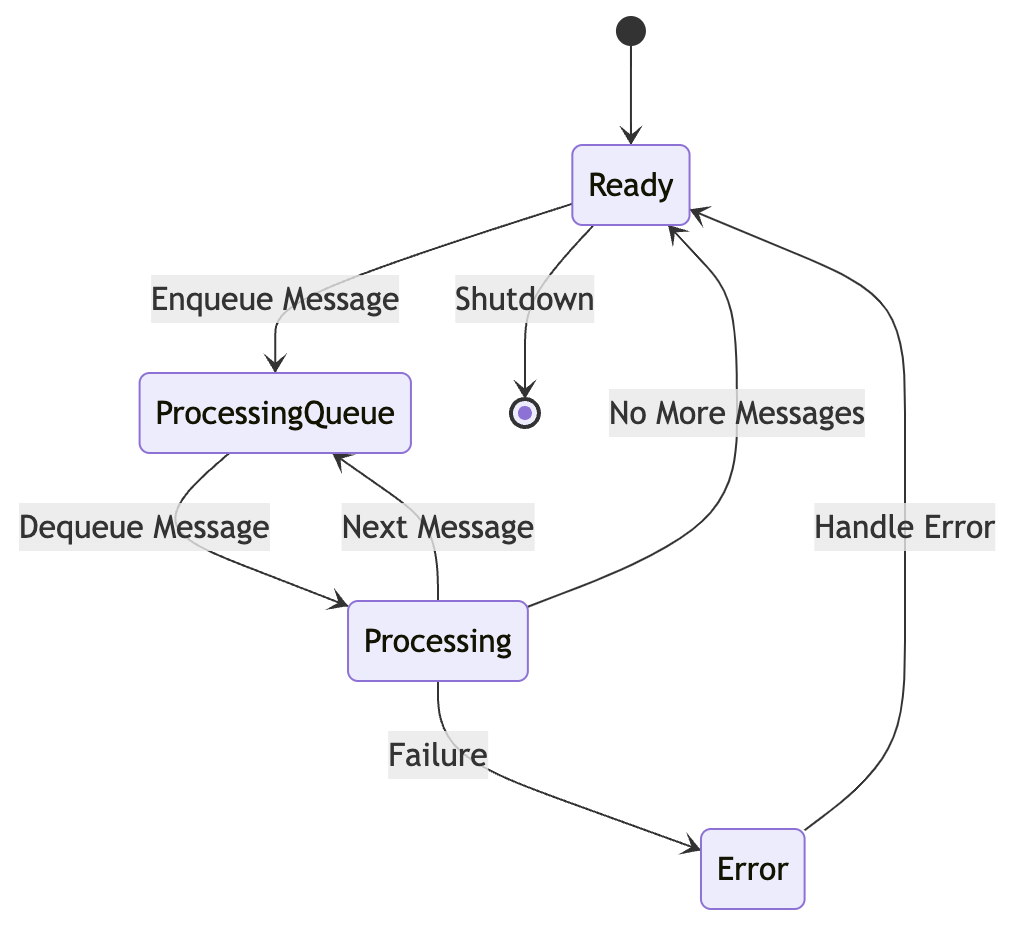

状态机图与当前状态

状态机图:直观展示状态之间的转换关系。

当前状态说明:

- Ready:代理处于空闲状态,准备接收输入。

- ProcessingQueue:代理正在管理消息队列。

- Processing:代理正在处理消息。

- Error:代理在处理过程中遇到错误。

未来扩展方向

- 高级工具集成:结合更多复杂工具并为其设置专门状态。

- 持久化存储:实现对话历史和状态的持久化。

- 自动重试:为失败操作添加重试机制。

- 目标导向行为:引入目标跟踪和规划能力。

- 多代理协调:协调多个代理之间的行为。

- 上下文管理:管理上下文切换和并行对话。

应用场景

- 研究助手:构建可搜索学术数据库(如 arXiv)并总结论文的 AI 代理,通过排队处理、异步执行和状态跟踪来完成任务。

- 客户支持机器人:开发用于客户服务交互的聊天机器人,实现有状态的对话、错误处理以及与 API 的集成。

- 数据管道自动化:创建自动化数据处理任务的代理,实现任务调度、资源管理和监控记录。

结论

Agent State Machine 为 LLM 代理的管理带来了全新的思路和方法,期待你在实际应用中探索更多的可能性。

如果在使用过程中有任何疑问或者心得,欢迎在评论区分享交流!

- 用 Rust 和 Bevy 打造一款 3D 孤独的公路游戏 56 浏览

- LUKSO、Monerium 和 IPOR 在 Wake Arena 上的应用 62 浏览

- 如何向AI Agent (而不是人类)推销自己 98 浏览

- 🎉 新年快乐!送你一只开源桌面宠物机器人 180 浏览

- Rust深入篇:桌面宠物助手的进阶玩法与架构设计 204 浏览

- 我对当前预测市场的状态感到担忧 225 浏览