Vitalik: AI为引擎,人类为方向盘

- Vitalik Buterin

- 发布于 2025-03-01 12:28

- 阅读 2607

文章探讨了如何利用AI在民主结构中获取益处,同时避免其缺点。重点介绍了通过AI作为引擎,人类作为方向盘的模式,以及通过竞争性开放市场和AI结合的方式来实现这一目标。

特别感谢 Devansh Mehta、Davide Crapis 和 Julian Zawistowski 的反馈和审阅。

如果你问人们为什么喜欢民主结构,无论是政府、工作场所还是基于区块链的 DAO,你经常会听到同样的论点:它们避免了权力的集中,它们为用户提供了强有力的保证,因为没有一个人可以随心所欲地完全改变系统的方向,并且它们可以通过收集许多人的观点和智慧来做出更高质量的决策。

如果你问人们他们不喜欢民主结构的地方,他们通常会给出同样的抱怨:普通选民并不复杂,因为每个选民只有很小的机会影响结果,很少有选民会对他们的决策进行高质量的思考,而且你经常会遇到低参与度(使系统容易被攻击)或事实上的中心化,因为每个人都默认信任并复制某些影响者的观点。

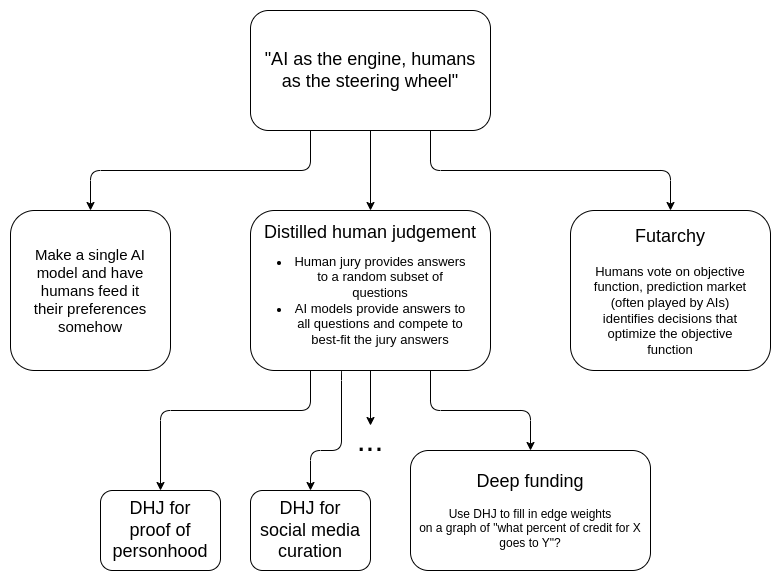

这篇文章的目标是探索一种范式,或许可以使用 AI 来获得民主结构的好处,而无需承担其缺点。“AI 作为引擎,人类作为方向盘”。人类只向系统提供少量信息,可能只有几百比特,但每一个比特都是经过深思熟虑且非常高质量的。AI 将这些数据视为“目标函数”,并孜孜不倦地做出大量决策,尽力满足这些目标。特别是,本文将探讨一个有趣的问题:我们能否在不将单一AI 置于中心的情况下做到这一点,而是依赖一个任何 AI(或人类-AI 混合体)都可以自由参与的竞争性开放市场?

目录

- 为什么不让一个单一的 AI 负责?

- Futarchy

- 提炼的人类判断

- 深度资助

- 添加隐私

- 引擎 + 方向盘设计的好处

为什么不让一个单一的 AI 负责?

将人类偏好插入基于 AI 的机制的最简单方法是制作一个单一的 AI 模型,并以某种方式让人类将他们的偏好输入其中。有一些简单的方法可以做到这一点:你可以将一个包含人们指令列表的文本文件放入系统提示中。然后你使用众多“代理 AI 框架”之一,让 AI 能够访问互联网,将你组织的资产和社交媒体资料的钥匙交给它,然后你就完成了。经过几次迭代,这可能足以满足许多用例,我完全预计在不久的将来,我们会看到许多涉及 AI 的结构,这些 AI 读取由群体给出的指令(甚至实时读取群聊)并因此采取行动。

这种结构不理想的地方是作为长期机构的治理机制。长期机构拥有的一个宝贵属性是可信的中立性。在我介绍这一概念的文章中,我列出了对可信中立性有价值的四个属性:

- 不要将特定的人或特定的结果写入机制中

- 开源且公开可验证的执行

- 保持简单

- 不要经常更改它

LLM(或 AI 代理)满足 0/4。该模型不可避免地通过其训练过程编码了大量特定的人和结果偏好。有时这会导致 AI 在某些令人惊讶的方向上产生偏好,例如,参见这项最近的研究,该研究表明,主要的 LLM 对巴基斯坦生命的重视程度远高于美国(!!)。它可以是开放权重的,但这与开源相去甚远;我们真的不知道魔鬼藏在模型的深处。它与简单相反:LLM 的 Kolmogorov 复杂度在数百亿比特,与所有美国法律(联邦 + 州 + 地方)加在一起的复杂度相当。而且由于 AI 的发展速度如此之快,你每三个月就必须更改一次。

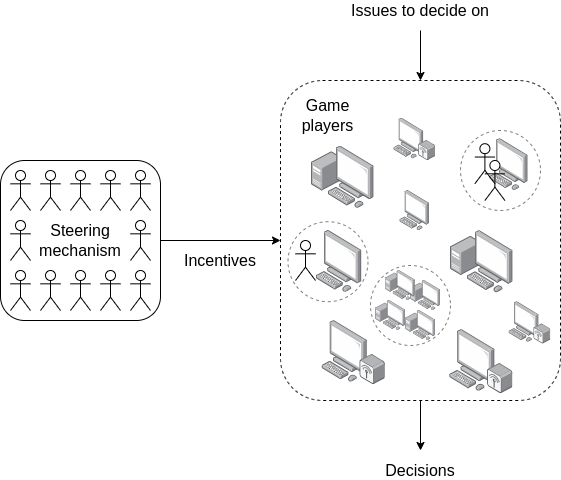

出于这个原因,我倾向于探索许多用例的替代方法是让一个简单的机制成为游戏规则,并让 AI 成为玩家。这与使市场如此有效的洞察力相同:规则是一个相对愚蠢的产权系统,边缘案例由法院系统决定,法院系统缓慢积累和调整先例,所有的智慧都来自“在边缘”运作的企业家。

单个“游戏玩家”可以是 LLM、相互交互并调用各种互联网服务的 LLM 群、各种 AI + 人类组合以及许多其他结构;作为机制设计者,你不需要知道。理想的目标是拥有一个作为自动机运行的机制——如果机制的目标是选择资助什么,那么它应该尽可能像比特币或以太坊的区块奖励。

这种方法的优点是:

- 它避免了将任何单一模型纳入机制;相反,你获得了一个由许多不同参与者和架构组成的开放市场,所有这些都有自己不同的偏见。开放模型、封闭模型、代理群、人类 + AI 混合体、赛博格、无限猴子等都是公平的;该机制不会歧视。

- 该机制是开源的。虽然玩家不是,但游戏是——这已经是一个相当成熟的模式(例如,政党和市场都是这样运作的)。

- 该机制很简单,因此机制设计者将自身偏见编码到设计中的途径相对较少。

- 该机制不会改变,即使底层玩家的架构需要从现在开始每三个月重新设计一次,直到奇点。

转向机制的目标是提供参与者底层目标的忠实代表。它只需要提供少量信息,但应该是高质量的信息。

你可以将这种机制视为利用提出答案和验证答案之间的不对称性。这类似于数独很难解决,但很容易验证解决方案是否正确。你(i)创建一个开放的玩家市场作为“解决者”,然后(ii)维护一个人类运行的机制,执行更简单的任务,即验证已提出的解决方案。

Futarchy

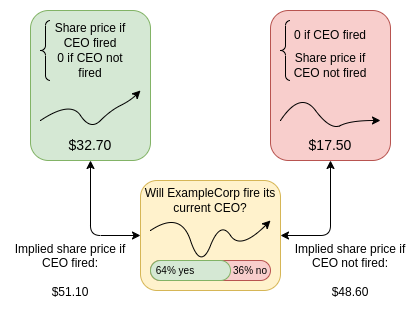

Futarchy 最初由 Robin Hanson 提出,即“投票价值,但押注信念”。一个投票机制选择一组目标(可以是任何东西,但需要注意的是它们需要是可衡量的),这些目标被组合成一个指标 M。当你需要做出决定时(为简单起见,假设是 YES/NO),你设置条件市场:你让人们押注(i)YES 或 NO 是否会被选择,(ii)如果选择 YES,M 的值,否则为零,(iii)如果选择 NO,M 的值,否则为零。给定这三个变量,你可以弄清楚市场认为 YES 还是 NO 对 M 的价值更乐观。

“公司股票的价格”(或者,对于加密货币,代币)是最常被引用的指标,因为它很容易理解和衡量,但该机制可以支持多种指标:月活跃用户、某些选民群体的自我报告中位数幸福感、某种可量化的去中心化度量等。

Futarchy 最初是在 AI 时代之前发明的。然而,futarchy 非常适合前一节中描述的“复杂的解决者,简单的验证者”范式,futarchy 中的交易者也可以是 AI(或人类 + AI 组合)。“解决者”(预测市场交易者)的角色是确定每个提议的计划将如何影响未来指标的价值。这很难。解决者如果正确就能赚钱,如果错误就会赔钱。验证者(对指标进行投票的人,如果发现指标被“游戏”或过时则调整指标,并在未来某个时间确定指标的实际值)只需要回答更简单的问题“现在指标的值是多少?”

提炼的人类判断

提炼的人类判断是一类机制,其工作方式如下。有大量(想象:100 万)问题需要回答。自然示例包括:

- 名单上的每个人对某个项目或任务的贡献应该获得多少信用?

- 这些评论中的哪些违反了社交媒体平台(或子社区)的规则?

- 这些给定的以太坊地址中哪些代表一个真实且独特的人类?

- 这些物理对象中的哪些对其环境的美学有积极或消极的贡献?

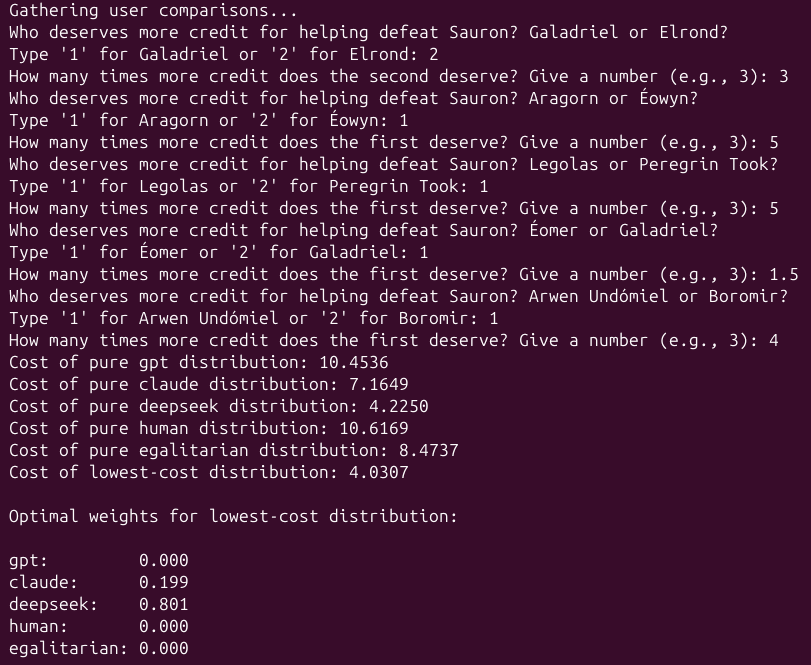

你有一个陪审团可以回答这些问题,尽管每个答案都需要花费大量精力。你只让陪审团回答一小部分问题(例如,如果总列表有 100 万个项目,陪审团可能只提供其中 100 个的答案)。你甚至可以问陪审团间接问题:不是问“Alice 应该获得总信用的百分之多少?”,而是问“Alice 或 Bob 应该获得更多信用,多少倍?”。在设计陪审团机制时,你可以重用现实世界中经过时间考验的机制,如拨款委员会、法院(确定判决的价值)、评估等,当然陪审团参与者自己欢迎使用新奇的 AI 研究工具来帮助他们得出答案。然后你允许任何人提交对整个问题集的数字响应列表(例如,提供对列表中每个参与者的信用估计)。鼓励参与者使用 AI 来做到这一点,尽管他们可以使用任何技术:AI、人类-AI 混合体、可以访问互联网搜索并能够自主雇佣其他人类或 AI 工作人员的 AI、赛博格增强的猴子等。一旦完整列表提供者和陪审团都提交了他们的答案,完整列表将与陪审团答案进行核对,并采用与陪审团答案最兼容的完整列表的某种组合作为最终答案。提炼的人类判断机制与 futarchy 不同,但有一些重要的相似之处:

- 在futarchy中,“解决者”正在做出预测,他们的预测被检查的“真实数据”(以奖励或惩罚解决者)是输出指标价值的预言机,由陪审团运行。

- 在提炼的人类判断中,“解决者”正在提供对大量问题的答案,他们的预测被检查的“真实数据”是对这些问题的一小部分的高质量答案,由陪审团提供。

在这个“击败索伦”的例子中,“人类作为方向盘”的方面体现在两个地方。首先,在每个单独的问题上应用了高质量的人类判断,尽管这仍然利用陪审团作为“技术官僚”的绩效评估者。其次,有一个隐含的投票机制来确定“击败索伦”是否是正确的目标(而不是,比如说,试图与他结盟,或向他提供某个关键河流以东的所有领土作为和平的让步)。还有其他提炼的人类判断用例,其中陪审团的任务更直接地涉及价值观:例如,想象一个去中心化的社交媒体平台(或子社区),陪审团的工作是将随机选择的论坛帖子标记为遵守或不遵守社区规则。

提炼的人类判断范式中有一些开放的变量:

- 你如何进行抽样?完整列表提交者的角色是提供大量答案;陪审团的作用是提供高质量的答案。我们需要选择陪审团,并为陪审团选择问题,以便模型匹配陪审团答案的能力最能表明其整体表现。一些考虑因素包括:

- 专业知识与偏见的权衡:熟练的陪审团通常在其专业领域内是专业的,因此通过让他们选择评分内容,你将获得更高质量的输入。另一方面,太多的选择可能会导致偏见(陪审团偏爱与他们有联系的人的内容),或抽样中的弱点(某些内容被系统地留下未评分)。

- 反Goodharting:会有内容试图“游戏”AI 机制,例如,生成大量看起来令人印象深刻但无用的代码的贡献者。这意味着陪审团可以检测到这一点,但静态 AI 模型除非努力尝试,否则不会检测到。捕捉这种行为的一种可能方法是添加一个挑战机制,个人可以通过该机制标记此类尝试,确保陪审团对其进行判断(从而激励 AI 开发人员确保正确捕捉它们)。如果陪审团同意,标记者将获得奖励,如果陪审团不同意,标记者将支付罚款。

- 你使用什么评分函数?当前深度资助试点中使用的一个想法是询问陪审团“A 或 B 应该获得更多信用,多少倍?”。评分函数是

score(x) = sum((log(x[B]) - log(x[A]) - log(juror_ratio)) ** 2 for (A, B, juror_ratio) in jury_answers):也就是说,对于每个陪审团答案,它询问完整列表中的比率与陪审团提供的比率有多远,并添加与距离平方(在对数空间中)成比例的惩罚。这是为了表明评分函数的设计空间很丰富,评分函数的选择与你向陪审团提出的问题的选择有关。 - 你如何奖励完整列表提交者?理想情况下,你希望经常给多个参与者非零奖励,以避免机制的垄断,但你也希望满足一个参与者不能通过多次提交相同(或稍作修改)的答案集来增加他们的奖励。一个有希望的方法是直接计算与陪审团答案最匹配的完整列表的线性组合(系数非负且总和为 1),并使用相同的系数来分配奖励。也可能有其他方法。

总的来说,目标是采用已知有效且偏见最小化并经受住时间考验的人类判断机制(例如,想想法院系统的对抗结构如何包括争议的双方,他们拥有高信息但可能有偏见,以及法官,他们拥有低信息但可能无偏见),并使用 AI 的开放市场作为这些机制的高保真且非常低成本的预测器(这类似于 LLM 的“蒸馏”工作方式)。

深度资助

深度资助是将提炼的人类判断应用于填充图边缘权重的问题,表示“X 的百分之多少的信用属于 Y?”最容易通过一个例子直接展示这一点:

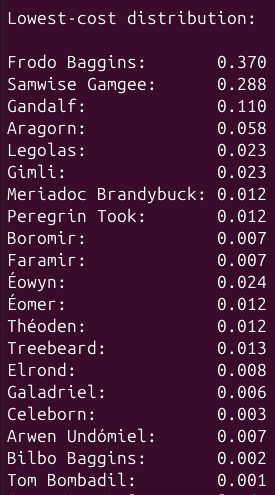

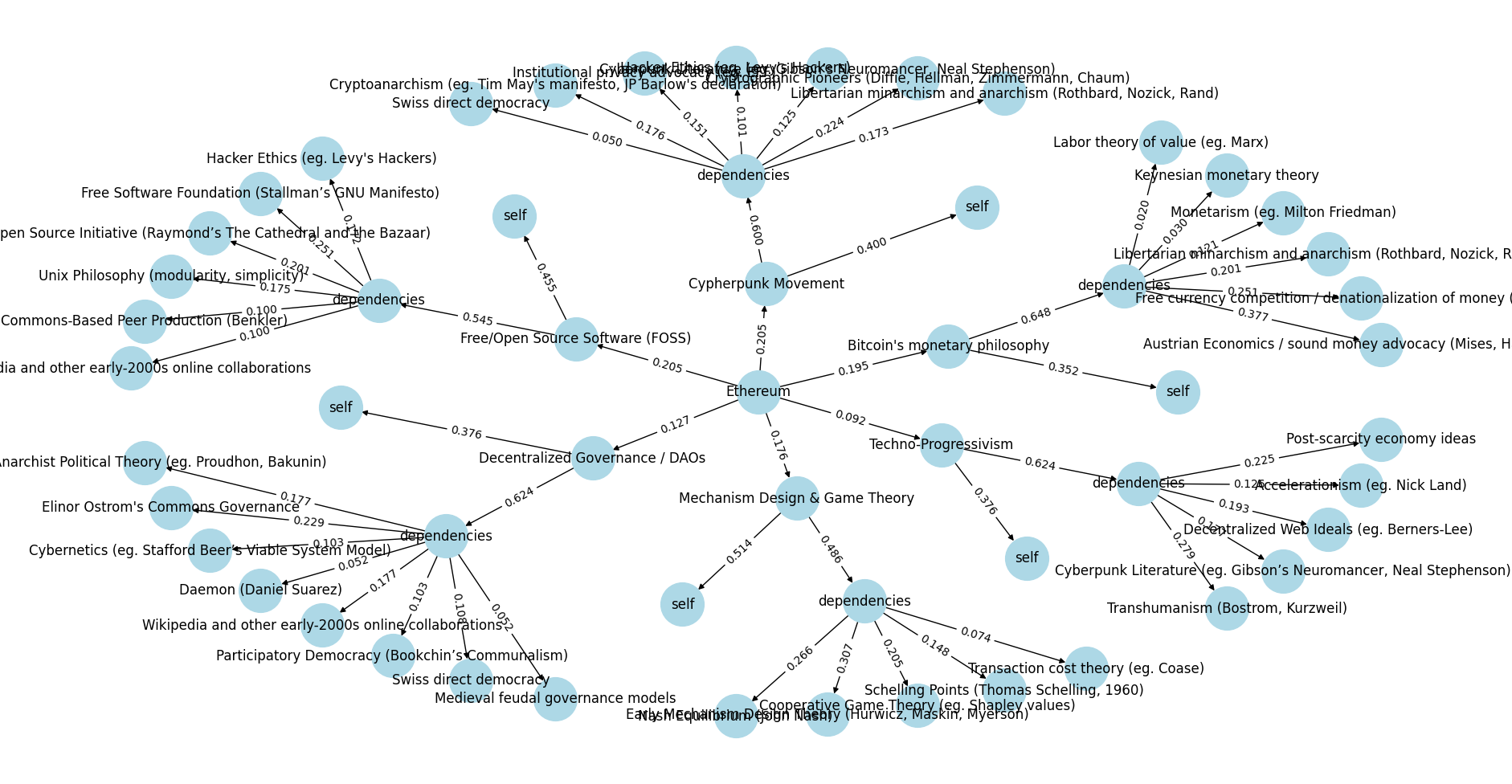

两级深度资助示例的输出:以太坊的思想起源。参见 此处的 python 代码。

这里的目标是分配导致以太坊的哲学贡献的信用。让我们看一个例子:

- 这里显示的模拟深度资助轮次将 20.5% 的信用分配给了密码朋克运动,9.2% 的信用分配给了技术进步主义。

- 在这些节点中的每一个节点中,你都会问一个问题:它在多大程度上是原始贡献(因此它应该为自己获得信用),以及在多大程度上是其他上游影响的重组?对于密码朋克运动,它是 40% 的新贡献和 60% 的依赖。

- 然后你可以查看这些节点的进一步上游影响:自由意志主义的小政府主义和无政府主义获得了密码朋克运动的 17.3% 的信用,但瑞士的直接民主只获得了 5%。

- 但请注意,自由意志主义的小政府主义和无政府主义也启发了比特币的货币哲学,因此它通过两种途径影响了以太坊的哲学。

- 要计算自由意志主义的小政府主义和无政府主义对以太坊的总贡献份额,你将沿着每条路径乘以边缘,并添加路径:

0.205 * 0.6 * 0.173 + 0.195 * 0.648 * 0.201 ~= 0.0466。因此,如果你必须捐赠 100 美元来奖励所有激励以太坊哲学的人,根据这个模拟的深度资助轮次,自由意志主义的小政府主义者和无政府主义者将获得 4.66 美元。

这种方法设计用于工作建立在前人工作之上且结构高度清晰的领域。学术界(想想:引用图)和开源软件(想想:库依赖和分叉)是两个自然示例。

一个良好运作的深度资助系统的目标是创建和维护一个全局图,任何有兴趣支持某个特定项目的资助者都可以将资金发送到代表该节点的地址,资金将根据图边缘的权重自动传播到其依赖项(并递归地传播到它们的依赖项等)。

你可以想象一个去中心化协议使用内置的深度资助小工具来发行其代币:一些协议内的去中心化治理将选择陪审团,陪审团将运行深度资助机制,协议自动发行代币并将其存入与自身对应的节点。通过这样做,协议以程序化的方式奖励其所有直接和间接的贡献者,类似于比特币或以太坊区块奖励奖励一种特定类型的贡献者(矿工)。通过影响边缘的权重,陪审团获得了一种持续定义其价值贡献类型的方式。这种机制可以作为挖矿、销售或一次性空投的去中心化和长期可持续的替代方案。

添加隐私

通常,对上述示例中的问题做出良好判断需要访问私人信息:组织的内部聊天记录、社区成员机密提交的信息等。对于较小规模的上下文,“只使用一个单一的 AI”的一个好处是,让一个 AI 访问信息比让所有人公开访问信息更容易接受。为了使提炼的人类判断或深度资助在这些上下文中工作,我们可以尝试使用加密技术安全地让 AI 访问私人信息。想法是使用多方计算(MPC)、全同态加密(FHE)、可信执行环境(TEE)或类似机制使私人信息可用,但只提供给那些唯一输出是“完整列表提交”并直接放入机制的机制。如果你这样做,那么你必须将机制集限制为只是 AI 模型(而不是人类或 AI + 人类组合,因为不能让人类看到数据),特别是运行在某些特定基板(例如 MPC、FHE、可信硬件)中的模型。一个主要的研究方向是找到近期的实用版本,这些版本足够高效以有意义。

引擎 + 方向盘设计的好处

这样的设计有许多有前景的好处。迄今为止最重要的是它们允许构建 DAO,其中人类选民负责设定方向,但他们不会被过多的决策所压倒。它们达到了一个快乐的中间地带,每个人不必做出 N 个决策,但他们比只做一个决策(通常如何委派工作)拥有更多的权力,并且以一种更能够引出难以直接表达的丰富偏好的方式。此外,这样的机制似乎具有激励平滑的特性。我在这里所说的“激励平滑”是两个因素的结合:

- 扩散:投票机制采取的任何单一行动都不会对任何一个单一行动者的利益产生过大的影响。

- 混淆:投票决策与它们如何影响行动者利益之间的联系更加复杂且难以计算。

这里的术语混淆和扩散取自密码学,它们是使密码和哈希函数

- 原文链接: vitalik.eth.limo/general...

- 登链社区 AI 助手,为大家转译优秀英文文章,如有翻译不通的地方,还请包涵~

- 一切皆市场 210 浏览

- 用 Rust + Bevy 游戏引擎打造一个可爱的桌面宠物伙伴 190 浏览

- 我在加密货币领域进行智能体工程的工作流程 227 浏览

- AI 正热,加密货币遇冷,那又如何? 415 浏览

- 互联网已死,Agent 永生 245 浏览

- AI如何帮助我们研究一起320万美元的黑客攻击:一个未经验证的智能合约中的漏洞剖析 494 浏览

- 回顾 2025,展望 2026 1059 浏览

- 预测市场未来形态 608 浏览

- $META 看涨情景分析 662 浏览

- 我们需要更多的DAO,但需要不同且更好的DAO 423 浏览

- 未来十年最应掌握的技能 710 浏览

- MetaDAO:互联网的新资本形成层 769 浏览