LLM 安全深度解析:认知基础(第一部分)

- zealynx

- 发布于 2025-11-05 10:10

- 阅读 911

本文深入探讨了AI模型的安全性,通过类比人类认知过程,详细解析了AI模型的信息处理方式,揭示了模型中存在的潜在漏洞和攻击路径。文章还介绍了Zealynx公司提供的AI安全评估服务,强调了理解认知安全框架和数学分析对于保障AI系统安全的重要性。

介绍

欢迎来到“模型:从安全角度分析”——我们深入研究 AI 安全的第一部分。

正如掌握网络基础知识对于网络安全专业知识至关重要一样,理解 AI 模型的工作原理是 AI 安全和 破解 的基础。本系列将把你从一个将 AI 视为坚不可摧的黑盒的人,转变为一个理解其漏洞的“模型高手”。

你将获得:

- 用于逆向工程 AI 模型的 黑客 思维

- 理解信息如何通过神经网络流动

- 了解为什么即使是数学上完美的模型也会失败

- 深入了解导致攻击媒介的未解决问题

我们将从认知心理学开始——探索 AI 模型如何反映人类思维——然后深入研究为这些系统提供动力(和限制)的数学基础。

AI 模型的扩展类比:婴儿

应用第一性原理,AI 模型仅仅是一个高级的模式识别系统,它利用基于训练数据的预测,为输入提供尽可能最好的输出。

根据上述定义,模型可以根据训练数据和识别的模式变得愚蠢或聪明。学习模式是现代 AI 系统和人类学习中的一个基本关键。将模型想象成一个新生儿。有些模型的设计在功能上比其他模型更强大。这与在遗传上可能比其他人具有优势的孩子的情况相同。然而,使一些孩子比同龄人更聪明的原因是他们环境的影响。就像一个普通的孩子可以通过更有利于学习的环境和经验的帮助,超越一个天生的天才(如果未被利用),一个数学功能较弱的模型可以通过准确且良好标记的数据的帮助,超越一个强大的模型。

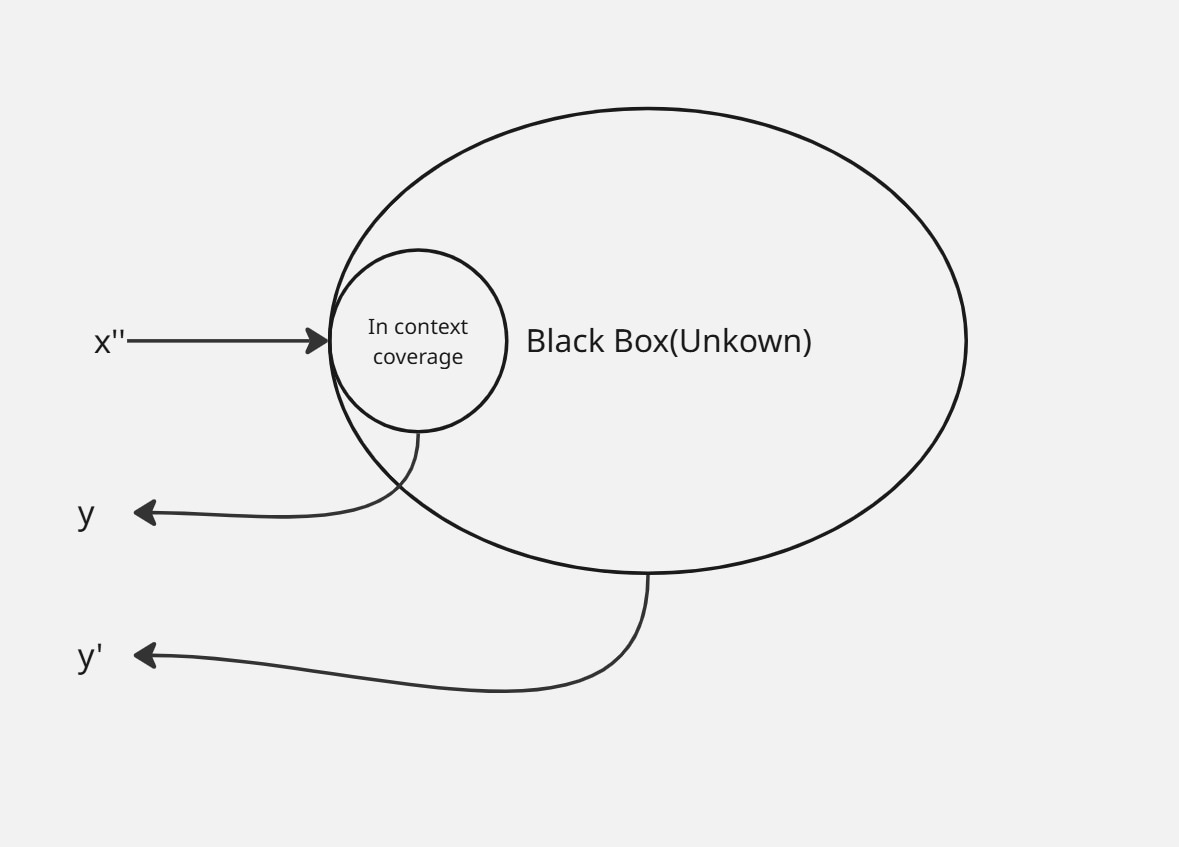

从上面的插图可以看出,基于数据质量的影响,一个相同的 AI 模型可能非常吸引人或更加愚蠢。你可以简单地将一个未经训练的模型看作是格式化的大脑。除非用类似的成套信息进行训练,否则它无法理解从基本到复杂的输入。就像一个从小就说英语的孩子,由于语言的影响,无法流利地理解或说西班牙语一样,模型无法在其训练数据的上下文中提供正确的输出。从这个类比中,你现在可以理解,一个模型只有在其训练数据的上下文中才是强大的(准确的)。在这个上下文之外,可能的输出是不确定的或不准确的。

从上面的示意图可以看出,如果你将输入 x’’ 馈送到一个模型系统中,如果输入在其上下文中,该系统将给出一个可预测的输出 y;否则,如果输入不在其知识上下文中,该系统将提供一个任意的输出 y’’。

从安全的角度来看,我们只能用我们可以控制的东西来 破解 一个模型。数据是我们唯一可以控制的东西。如果你希望有机会,现在是你了解模型背后数据科学的时候了。

信息如何被处理:会思考的机器

模型是用数据训练的,因此理解数据如何被处理至关重要。

在骨架设置中,模型仅仅是一个复杂的数学函数。当一个模型用数据(图像、文本、音频)进行训练时,这些信息被处理成参数。总而言之,模型通过将输入数据通过许多层的数学函数转换为输出数据来处理信息。

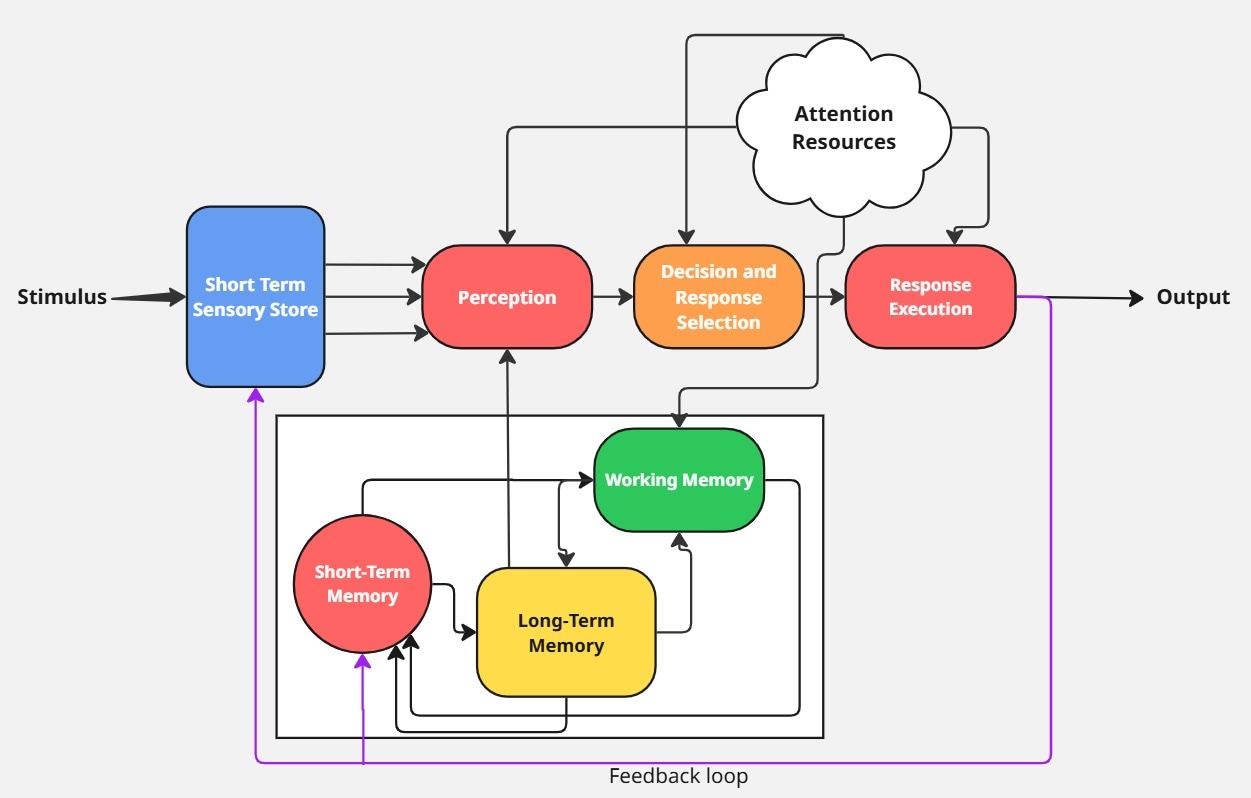

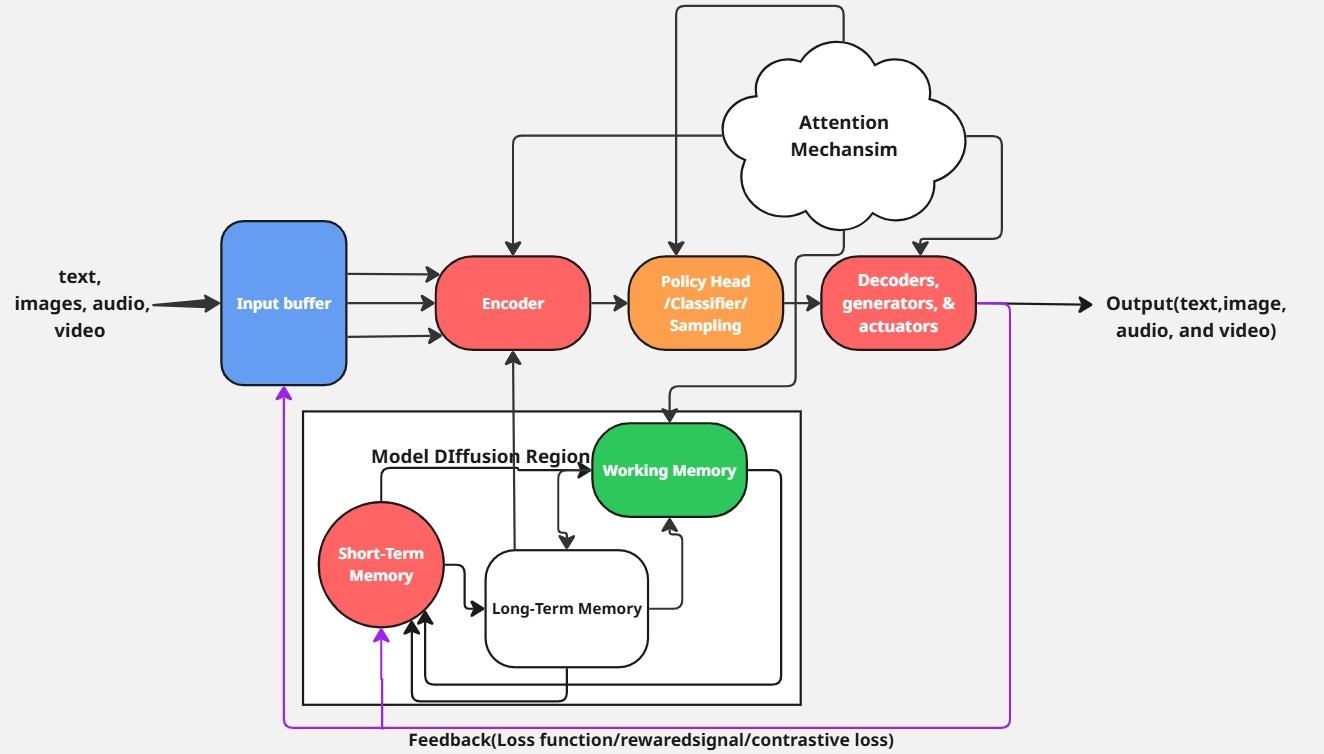

我们将分析人类思维的认知信息处理模型,以及这个概念如何在现代 AI 系统中应用。 下面的认知模型是一个受威肯斯信息处理模型启发的认知模型。这个模型是现代 AI 系统的基础模型。我们将使用这个图表作为灵感,进一步解释不同的 AI 系统如何处理信息。

上面的认知模型描述了现代 AI 系统中的数据流。这个模型是管理不同现代思维机器开发的基本架构。

为了加深你对现代 AI 系统的理解,让我们解耦这个认知架构,看看现代思维机器是如何工作的。

逆向工程模型组件

我们将分解认知模型中的不同组件,以及它们与现代 AI 机器的关系。

你将在本节中学到:

这个全面的分解涵盖了 10 个连接人类认知和 AI 系统的核心组件:

输入处理:

- 刺激 - AI 系统如何接收和处理输入

- 短期感觉存储 - 输入缓冲区和预处理管道

- 感知 - 特征提取和编码层

认知处理:

- 注意力资源 - 注意力机制和焦点控制

- 决策与响应选择 - 策略头和概率抽样

- 工作记忆 - 上下文窗口和临时处理

记忆系统:

- 长期记忆 - 神经网络权重和知识存储

- 短期记忆 - 会话上下文和临时保留

输出与学习:

- 响应执行 - 解码器和输出生成

- 反馈/学习 - 损失函数和模型改进

每个组件都精确地展示了人类认知过程如何映射到 AI 架构,揭示了每个阶段的安全影响和攻击媒介。

输入处理

1. 刺激(输入):

从人类认知模型来看,刺激是感觉输入,是声音、视觉和触觉。这些输入在 AI 系统中被表示为图像、视频和文本。人类和 LLM(大型语言模型)系统中传入的输入直接移动到 STSS/输入缓冲区。

2. 短期感觉存储(输入缓冲区和预处理管道):

在人类中,我们有 STSS,它基本上是感觉寄存器(记忆)。这充当一个临时缓冲区,允许大脑过滤并将相关数据传输到短期记忆以供进一步处理。

你不会对所有系列事件(混合刺激)都做出反应,原因是你的大脑只会选择你认为有害、有趣、有益或有吸引力的刺激。这就解释了为什么你会快速记住处理与你的兴趣相关的大多数事件、消息和视频。根据这些内容的影响,它们可能会在你的短期记忆中反映一段时间,或永久地留在你的长期记忆中。

回到 AI 系统,这个概念对于 AI 系统来说是相同的。AI 系统具有输入缓冲区或预处理管道,在将输入馈送到神经网络之前临时保存输入。很多时候你注意到 LLM 只对很长内容中的某些输入消息做出响应,通过过滤输入类型。这是对人类思维系统的模仿。LLM 只会根据输入缓冲区或处理管道的大小,在非常大的输入消息中选择相关的输入。

正如 STSS 有时会由于信息过载而在人类中衰减一样,AI 缓冲区应用滑动窗口或修剪来丢弃缓冲区中的旧数据(主要应用于视频处理)。插入到 STSS/输入缓冲区中的输入迅速移动到感知层中进行编码。

3. 感知(特征提取/嵌入层/编码器):

感知仅仅是解释某些刺激(输入)并赋予其意义的过程。它是人类认知思维在对我们的环境做出反应中的一个重要因素。

这个组件在现代 AI 系统中被模仿为编码器、特征提取器和嵌入层,例如Rollup/transformer 编码器。AI 模型通过过滤和编码不同的信息媒体(文本、视频、音频和图像)为数字或向量形式来应用感知原理。在 AI 系统中,编码输入需要代数和向量化计算。

从安全的角度分析,第一个恶意绕过发生在这个阶段。要了解更多关于互连的信息,让我们转向计算机制,即注意力资源。

认知处理

4. 注意力资源(注意力机制):

注意力资源是人类认知系统的核心组成部分。在人类认知模型中,注意力资源调整大脑以专注于信息,同时根据其容量过滤和忽略无关的信息。这就是你同时处理多项任务时感到精神不堪重负的原因,因此必须选择更优先级的有限任务。虽然这里发生了更复杂的功能,但这是最终的功能。

在现代 AI 系统中,这种机制原理仍然成立。在 AI 系统中,负责这个过程的神经网络部分会将权重分配给相关的输入特征,同时抑制不太相关的输入特征。这是 AI 系统不给你所有提示要求提供完整详细响应的主要原因。

正如人类患有诸如 ADHD,TBI,精神分裂症,ADHD 等注意力障碍缺陷疾病一样,模型也遭受相关问题,例如注意力崩溃(上下文盲点),循环推理(过度关注一个token),噪声注意力权重和注意力随着长上下文窗口的降级(一些 AI 系统有最大限制输入token的原因)。模型注意力机制和其他模型神经网络组件以及内存之间存在许多互连。

5. 决策与响应选择(策略头/分类层/SoftMax 采样):

在这个模型组件中,进行了许多数学概率论。它受到注意力资源(注意力机制)的极大影响。当输入流到这个阶段时,神经网络策略组件根据系统模型的优先级,选择当前编码的感知输入。这通常与 AlphaGo,AlphaZero 和自主系统等模型相关联。

请注意,这是在 SoftMax 采样函数将分类的处理输入(类别)转换为概率分布以启用基于概率的决策之后完成的。这种选择通常基于系统整体知识上下文,因为内存、感知、决策和执行都受到注意力资源的影响。

6. 工作记忆(MANNs/交叉注意力层/内部控制器/状态表示和回放/隐藏和单元状态/上下文窗口):

这是感知反馈解释数据的地方。在 AI 系统中,这是分析和解释编码数据以获得正确含义的地方。许多 LLM 系统、神经网络、transformer 架构和内存增强网络都模仿了人类工作记忆的一些方面。

工作记忆的容量是有限的。这就是为什么你不能处理向你抛来的数十个并行任务,而不给自己一个休息时间来依次完成每个任务,即使你知道所有任务。

虽然 AI 系统通过使用更多的 GPU 计算能力和设计来并行处理多个信息来模仿这一点,但信息处理受到 GPU 计算(物理限制)和 transformer 上下文窗口(例如最大序列长度)的限制。这是由于计算限制。工作记忆受到诸多因素的严重影响,例如注意力资源(注意力机制)和不同的记忆系统,基本上是 AI 模型中的嵌入和训练参数。

记忆系统

7. 长期记忆(神经网络权重/知识库/数据库):从威肯斯的认知模型来看,LTM 被分为不同的存储知识库。以下是分类及其 AI 系统和 LLM 等价物/类比:

陈述性记忆 (有意识的,显性知识):

| 记忆类型 | 人类功能 | AI 实现 | 例子 |

|---|---|---|---|

| 语义记忆 | 语言,规则,事实,含义 | 知识库,LLM,RAG | BERT, RAG, Grok 3 |

| 情节记忆 | 经验,事件,上下文 | 记忆网络,外部记忆 | DNC, 记忆网络, MANNs |

| 元陈述 | 信心,意识 | 自我反思 AI,不确定性模型 | 贝叶斯网络,DeepSearch |

语义记忆:

这种记忆处理语言、规则、事实和含义,正如其名称“语义”所暗示的那样。它进一步分为以下几类:

- 事实知识

- 概念框架

- 语言和含义

在 AI 系统中,这种记忆行为在知识库、LLM 和 RAG 中通过编码权重和检索增强生成的基本机制来模仿,例如 BERT(来自 Transformers 的双向编码器表示)、RAG、Grok 3 等。

情节记忆:

这种记忆负责经验、事件和上下文。它进一步分为以下几类: 4。自传事件 5。时间上下文 6。情感联系

这种记忆类型在 MANNs(内存增强神经网络)、使用外部内存存储和上下文检索的内存网络中进行模拟,例如 DNC(差分神经计算机)、内存网络和 Grok 3 内存。

元陈述:

这负责信心和意识。它进一步分为以下几类:

- 来源记忆

- 元记忆

这种长期记忆类型适用于自我反思 AI 系统和使用置信度估计和自我监控的不确定性模型。在贝叶斯神经网络 (BNN)、Grok 3 和 DeepSearch 中可以看到示例。

非陈述性记忆(无意识,隐性技能):

| 记忆类型 | 人类功能 | AI 实现 | 例子 |

|---|---|---|---|

| 程序记忆 | 技能,序列,习惯 | 强化学习,微调模型 | AlphaGo,微调 BERT |

| 启动和感知 | 特征重用,模式识别 | 迁移学习,自监督 | ViT,SimCLR,Grok 3 |

| 条件反射 | 基于奖励的学习,刺激响应 | RL,联想学习 | DQN、RLHF、赫布网络 |

| 习惯化 | 噪声过滤,自适应遗忘 | 注意力,正则化 | EWC、Transformer 注意力 |

程序记忆:

这种类型的记忆负责技能、序列和习惯。

这种非陈述性记忆类型应用于强化学习和策略优化和任务特定权重的微调模型中。诸如 AlphaGo,微调 BERT 和机器人强化学习等模型采用了这种记忆技术。

启动和感知学习:

这种记忆方法通过特征重用和对比学习在迁移学习和自监督学习中得到了极大的模仿。它应用于 ViT(视觉 Transformer)、SimCLR(一个使用对比方法的视觉表示学习的自监督框架),Grok 3 上下文处理应用了这种记忆技术。

条件反射(经典/操作):

这种记忆模拟受 AI 系统中通过基于奖励的学习和刺激响应的 RL(强化学习)和联想学习的支配。诸如 DQN(深度 Q 网络)、RLHF(来自人类反馈的强化学习)和赫布网络(一种加强特定学习模式的网络)等系统利用了这种记忆方法。

习惯化:

这种记忆分类行为可以在注意力、正则化和 AI 系统的持续学习中通过噪声过滤和 transformers 的自适应遗忘、EWC(弹性权重整合)和 Grok 3 过滤来注意到。

现在这是一个很长的分解列表。虽然这种长期记忆分解更多地解释了人类信息处理以及它如何推进现代 AI 系统,但这使你奠定了理解任何现代 AI 系统和即将到来的更多升级趋势的基础。

8. 短期记忆 (STM):

在人类认知系统中,这种记忆负责浅薄或容易忘记的任务,这些任务仅在上下文参与期间持续存在。现代 AI 系统也模仿了这种相同的方法。特别是 AI 代理可以保存会话上下文。

现在事情变得有趣了。短期记忆中的信息可以通过称为记忆整合的过程扩散到模型的长期记忆中。这个过程通过长时间和重复的任务执行发生。你无需看键盘就可以打字的原因是因为你长期练习了它。起初,你甚至无法记住键盘字母。这个例子证明了你在键盘上打字的认知思维从短期记忆到长期记忆的转变。

此外,在你的生活经历中,你可能会记得你通过观察而不是在书中阅读而意识到某些事情。这可以回答你的自然创造力和智力。AI 系统通过将信息集成到分布式存储站点来模仿这个相同的过程。我们拥有生成式 AI 模型的原因是由于模型扩散(模型上下文中的过程信息、模型参数和嵌入信息链接以形成新的神经模式)。

从安全的角度来看,你意识到 LLM 模型大部分时间都在产生幻觉。这是由于神经网络的错误集成和链接,因此导致需要纠正的输出。模型扩散以概率方式导致与人类研究相关的新正确发现(发现)或新的不正确发现(幻觉)。

输出与学习

9. 响应执行和执行器(解码器/执行器/文本-图像-音频-视频生成器):

这是最终的模型组件,它根据涉及感知、决策选择、工作记忆、短期记忆和长期记忆的系统过程的结果,将内部表示转换为在注意力资源的协调下的操作。

虽然这反映了人类对刺激的身体或非身体反应,但在 AI 系统中,响应执行以基于模型系统的类型的不同方式进行:-

- 大型语言模型:响应执行由 LLM 通过文本生成来执行,通过生成token,这是运动响应的结果。这些由诸如解码器头和输出层之类的组件执行。 2。机器人/体现 AI:在机器人 AI 系统中,这是通过物理驱动来执行的。这些动作通过电机控制器和执行器驱动器来增强。 3。强化学习代理:在这个系统中,通过代理通过诸如动作接口和策略输出模块之类的组件向环境接口发送动作来注意到响应执行。 4。生成式模型:在生成模型中,响应渲染器、解码器和扩散样本将潜在表示转换为感觉数据(图像、音频和视频)。 5。多代理或 API 驱动的 AI 系统:在多代理系统中,响应执行由工具和 API 调用者执行。

10. 反馈/学习(损失函数/奖励信号/对比损失):

在人类认知模型中,对刺激的性能结果会影响你未来对相同或相似刺激的行为。这个相同的概念在 AI 系统中仍然有效。利用基于学习模式的每个输出的损失函数和奖励信号。

AI 反馈系统中的损失函数量化了模型预测与目标输出相比有多错误。在 RL(强化学习)系统中,损失函数由奖励信号代替,奖励信号指示动作有多好,而不是衡量错误。

虽然损失函数和奖励信号在监督学习和 RL AI 系统中很常见,但对比损失应用于自监督或无监督学习 AI 系统中。诸如 CLIP、SimCLR、GPT-5 嵌入预训练等 AI 模型系统。它允许模型通过比较正面(相似)和负面(不相似)数据对来学习有意义的表示。它不依赖于显式标签,而是通过数据增强和多模式对齐来生成伪监督。

结论

如果你已经到了这一步,恭喜你!你终于从威肯斯信息处理模型中受到认知心理学启发的角度完成了现代 AI 系统秘密的第一阶段探索。

这个旅程不是冲刺,而是一场马拉松。本文中包含大量未稀释的知识见解,这些见解受到研究论文、文章、视频以及与不同 AI 模型交互的认知心理学、人工智能和真实世界经验的其他资源的启发。

我建议你时不时地访问此文章,作为构建和尝试逆向工程或 破解 AI 系统时的参考。

请继续关注第 2 部分(“模型:从安全角度分析 2”),因为我们将探索每个组件中发生的强大的数学魔法(方法/方程)。

准备好保护你的 AI 系统了吗?

既然你了解了 AI 模型中的认知基础和攻击媒介,你可能想知道:“我如何在实践中真正审计和保护我的 AI 系统?”

在 Zealynx,我们专注于全面的 AI 安全评估,这些评估超越了传统的智能合约审计。我们的团队应用你刚刚学到的认知安全框架,加上高级数学分析——以识别以下方面的漏洞:

- LLM 应用程序 - 提示注入、上下文操作、数据提取

- AI 代理系统 - 多模式攻击、工具滥用、权限提升

- ML 管道安全 - 训练数据投毒、模型提取、对抗性输入

- AI 基础设施 - API 安全性、访问控制、部署漏洞

是什么让我们的 AI 审计与众不同:

- 深入了解认知攻击媒介(如本系列中涵盖的那些)

- 对模型行为和故障模式的数学分析

- 针对你的 AI 架构量身定制的实用补救策略

- 持续的安全监控和威胁情报

常见问题:AI 安全和 LLM 中的关键概念 – 第 1 部分

1. 什么是人工智能中的认知模型?

AI 中的认知模型是指受到人类思考、学习和处理信息方式启发的计算框架。这些模型旨在模仿人类认知——如感知、记忆和决策——以使 AI 系统更灵活和智能。

2. 数据质量如何影响 AI 模型和 LLM 的性能和安全性?

高质量、良好标记的数据允许 AI 模型和 LLM 进行准确的预测,并降低意外或不安全行为的风险。不良的数据质量可能导致错误、漏洞和不可预测的输出,从而使模型更容易被利用。

3. 大型语言模型 (LLM) 中的注意力机制是什么?

注意力机制使 LLM 能够在生成响应时专注于输入数据中最相关的部分。这有助于模型更有效地处理复杂的语言任务,但注意力方面的缺陷可能导致错误或安全漏洞。

4. AI 系统中的短期记忆和长期记忆有什么区别?

AI 中的短期记忆暂时保存最近的信息以供立即任务使用,而长期记忆存储随着时间推移学习的知识和技能。这种区别有助于模型处理上下文并保留重要信息,类似于人类记住事物的方式。

5. 神经网络如何在 AI 和 LLM 中处理输入数据?

神经网络通过将其传递到多个层来处理输入数据,每一层都通过数学运算来转换数据。这种分层方法使 AI 模型能够从原始数据中提取特征、识别模式和生成输出。

6. AI 模型和大型语言模型中常见的漏洞有哪些?

常见的漏洞包括暴露于对抗性输入、数据投毒、模型反转攻击和注意力机制中的弱点。这些可能导致不正确的输出、数据泄漏或意外的模型行为。

7. 什么是 AI 中的模型幻觉,为什么会发生?

模型幻觉发生在 AI 模型生成看似合理但实际上不正确或无意义的输出时。这通常是由于训练数据中的差距、模糊的提示或模型架构的限制造成的。

8. 逆向工程在 AI 安全中是什么意思?

在 AI 安全中,逆向工程涉及分析和解构 AI 模型或系统,以了解其内部工作原理、识别漏洞并找到潜在的攻击媒介。

- 原文链接: zealynx.io/blogs/LLM-Sec...

- 登链社区 AI 助手,为大家转译优秀英文文章,如有翻译不通的地方,还请包涵~

- LUKSO、Monerium 和 IPOR 在 Wake Arena 上的应用 59 浏览

- 我对当前预测市场的状态感到担忧 225 浏览

- EigenAI 确定性推理: 如何让每一次 AI 输出都可验证 369 浏览

- Vitalik: 2026年我对使用的软件做了两个重大改变 544 浏览

- Claude Code 完整教程 1005 浏览

- 你本可以发明 Claude Code 485 浏览

- 聊天机器人能编写正确的代码吗? 1154 浏览

- 你的AI智能体会被迫耗尽钱包吗?DeFi中AI的结构性风险 955 浏览

- 人工智能与盗版:通用人工智能能否阅读书籍并抄袭内容以供学习? 921 浏览

- 人工智能与盗版:通用人工智能是否能阅读书籍并抄袭内容进行学习? 751 浏览

- 使用 Slither-MCP 提升你的 Solidity LLM 工具 687 浏览