2025年保密人工智能发展现状:谁是赢家,谁是输家

- Hazeflow

- 发布于 2025-05-24 18:45

- 阅读 1076

本文探讨了2025年保密人工智能的发展现状,重点关注了在AI处理敏感数据时如何保护数据安全的技术方案。文章深入分析了TEE、零知识证明(ZKP)、全同态加密(FHE)和多方计算(MPC)等关键技术,并探讨了它们在实际应用中的权衡与结合,以及在企业和Web3领域中的应用案例,强调了TEE在当前保密AI领域的重要性。

Hazeflow 是一家区块链研究公司。我们正在撰写关于区块链行业独特视角和观点的文章,并发布教育研究资料。

2025 年保密 AI 现状:谁是赢家,谁是输家

新一代工具正在涌现,以解决 AI 最关键的盲点:敏感数据被使用的那一刻。

每个 AI 很快都会处理敏感数据(或者已经在处理了)。

真正的问题是:它能否在不暴露数据的情况下做到这一点?

当 AI 处理你的信息时,比如健康诊断或财务数据,它比你想象的更暴露。虽然数据在存储或发送时是安全的,但当 AI 使用它时,数据就会变得脆弱。为了处理你的数据,AI 必须解密它,使其可读,并成为恶意软件或黑客的容易攻击目标。

如果在传统系统中这很冒险,那么在公共区块链上情况会更糟。

在去中心化基础设施中,大多数数据不仅在使用时暴露,而且还复制到数千个节点上。默认情况下,金融交易、智能合约输入、游戏逻辑和身份数据在全球范围内可见。

这种程度的透明度破坏了隐私。

-

交易者可能被抢先交易。

-

策略可能被复制。

-

头寸可能被实时利用。

对于像去中心化身份或信用评分这样的非金融用例,完全透明使得合规性和保密性几乎不可能实现。

这是迈向 可编程隐私 的更大趋势的一部分,在这种趋势中,技术不仅用于隐藏数据,还用于让不同的群体安全地使用和受益于数据,而无需暴露原始信息。Archetype 的 “Privacy 2.0”报告 通过 私有共享状态 的概念强调了这一点,即多方可以处理敏感数据集,同时保持其机密性。

这正是 保密 AI 旨在做的事情:安全地弥合“使用中”的差距,以便敏感的 AI 工作负载可以在可验证的安全环境下运行。

本文探讨了该差距是如何弥合的。我们将分解使保密 AI 成为可能的核心技术,检查它们的权衡,并了解谁已经在生产中使用它们。在此过程中,我们将看到为什么 2025 年标志着大规模的私有、实时 AI 不再是理论,而是开始成为基础设施的时刻。

保密 AI:弥合“使用中”的差距

保密 AI 正是为了解决这个确切的弱点:你的数据最脆弱的那一刻,即在推理期间 (AI 模型处理你的输入以生成结果的阶段,例如预测或答案)。

它使你的数据保持密封,不仅在之前和之后,而且在模型积极运行时。这包括:

-

输入:医疗扫描、投资策略、个人消息

-

模型:OpenAI、Anthropic 和 Meta 训练的专有 LLM

-

输出:模型产生的答案、建议或预测

核心思想:在密封的、防篡改的环境中运行模型,以便 任何人,甚至包括基础设施提供商,都无法检查内部发生的事情。

为什么保密 AI 现在更重要

企业在 LLM 项目上的支出已经超越了试点阶段。根据 2025 年 6 月对 100 位全球 CIO 的调查,AI 预算同比增长约 75%,现在被视为核心 IT 支出,不再局限于实验性计划或短期创新基金。

推动支出的用例:

-

即时文书工作:在医院,AI 工具自动将医患对话 转换为结构化的医疗笔记,从而减少了数小时的手动打字时间。

-

一线聊天和支持:公司使用低成本的开源 AI 来处理常见问题,并将昂贵的高级 AI 模型用于棘手或不寻常的情况。这种组合已将客户服务成本降低了 20–40%。

-

更快的创意工作:电影制片厂使用 AI 视频工具在几小时内而不是几周内完成视觉效果,从而加快了制作速度,而无需更换创意团队。

这些用例正在推动 AI 更深入地融入核心业务工作流程。但是,要释放更多价值,企业需要将强大的模型与私有数据安全地结合起来。这就是私有 AI 数据市场发挥作用的地方。

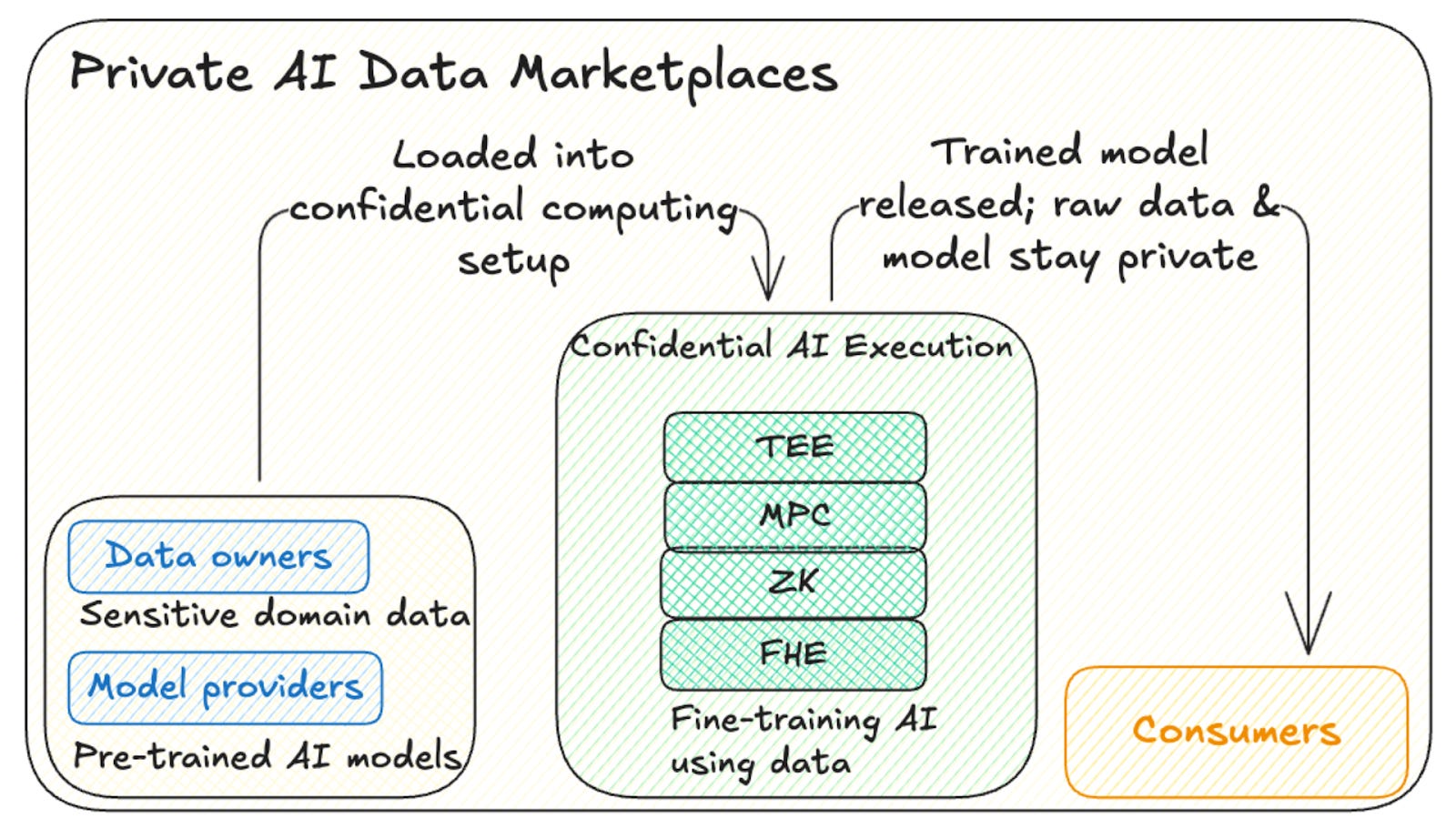

私有 AI 数据市场:下一个大前沿

-

模型供应商(例如,OpenAI)提供高质量的基础模型。

-

独立的数据所有者贡献专门的数据集,如医学扫描、卫星图像或客户对话,以针对其特定领域微调基础模型。

-

为什么保密性至关重要:模型参数是供应商的至宝;原始数据集是数据所有者的竞争优势。 在微调运行期间,两者都必须保持隐藏,但双方仍然需要密码学证明对方的行为是正确的。

-

是什么使其成为可能:保密计算让基础模型和私有数据集在密封的 enclave 中相遇,执行微调,并仅导出商定的权重:无窥视,无泄漏。

如果没有该保证,模型提供商和数据提供商都不愿意参与,并且市场停滞不前。

有了它,全新的数据换模型经济变得可行,从而在 2025 年 AI 支出激增中开辟了另一个主要的预算项目。

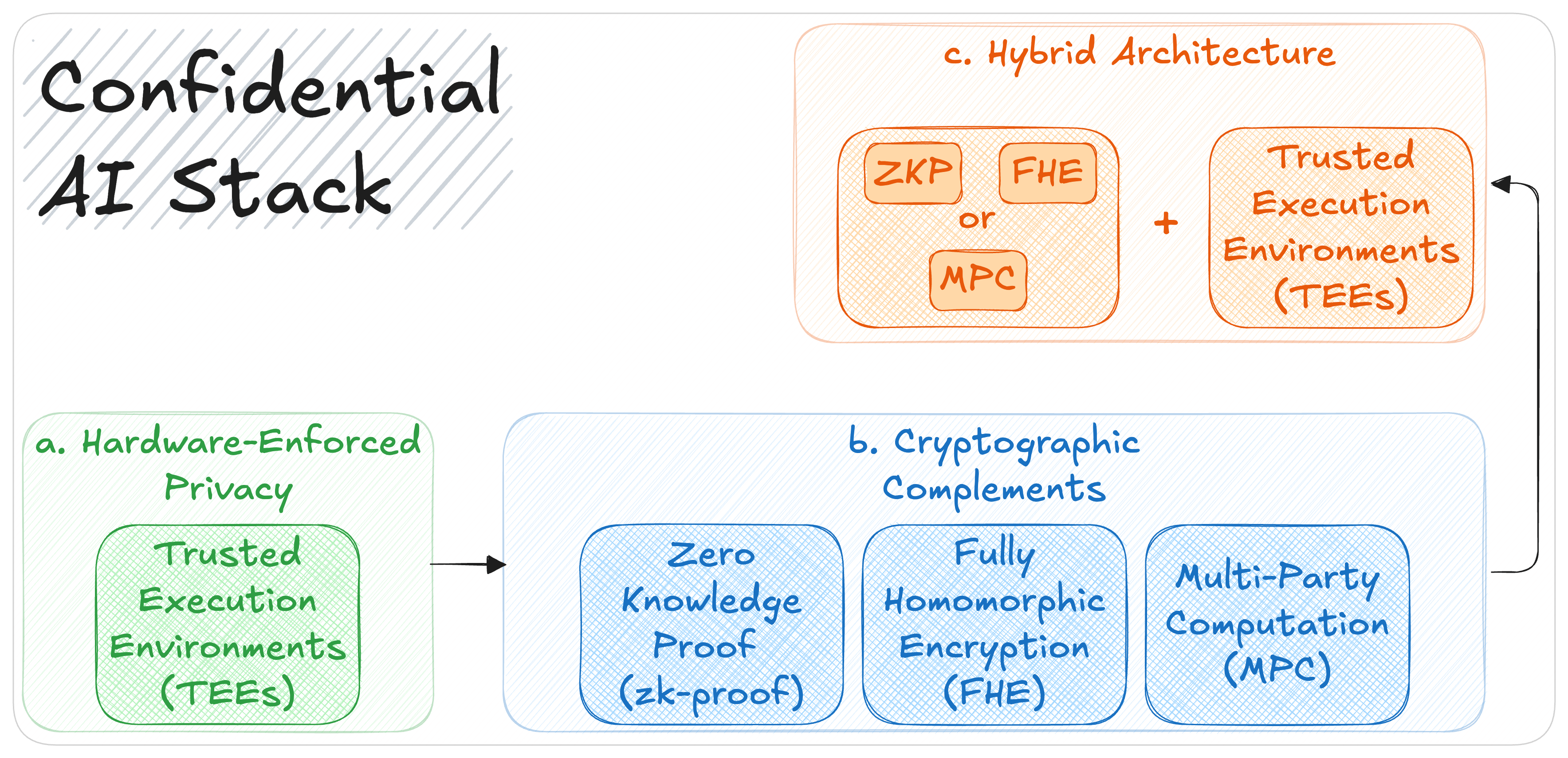

是什么使它成为可能:保密 AI 堆栈

保密 AI 的实现得益于基于硬件的隔离和高级密码学技术的结合。这些由三个关键组件提供,我们将在以下顺序中进行介绍:

1. TEE(硬件强制隐私)

TEE 是 CPU 或 GPU 内部的安全、隔离区域,可以在其中私密地处理数据。可以将其视为芯片内部的密封房间。一旦代码在那里运行,就无法对其进行篡改,并且没有人(甚至操作系统或云提供商)可以看到里面的内容。

对于 AI,这意味着输入(如病历)、模型权重(如专有 LLM)和输出(预测或评分)在模型积极运行的最脆弱阶段保持受到保护。

到 2025 年,TEE 已内置于大多数主要处理器中:Intel SGX/TDX、AMD SEV-SNP 和 Arm TrustZone。

AI 的最大飞跃来自 NVIDIA 的 H100 和 Blackwell GPU,它们将保密计算直接添加到高性能推理中,从而可以在共享硬件上安全地运行大型模型。

性能测试显示只有很小的减速:

-

吞吐量下降约 6–9%,生成第一个 token(初始响应)的时间增加约 20%。

-

在第一个 token 之后,生成速度几乎与没有 TEE 的运行速度相同,并且在某些情况下,如长提示或批量处理,性能几乎与非 TEE 运行相同。

主要的权衡是,你仍然需要信任硬件供应商并保持系统其余部分的安全性。

底线:如果你现在需要在敏感数据上进行实时 AI,请从 TEE 开始。

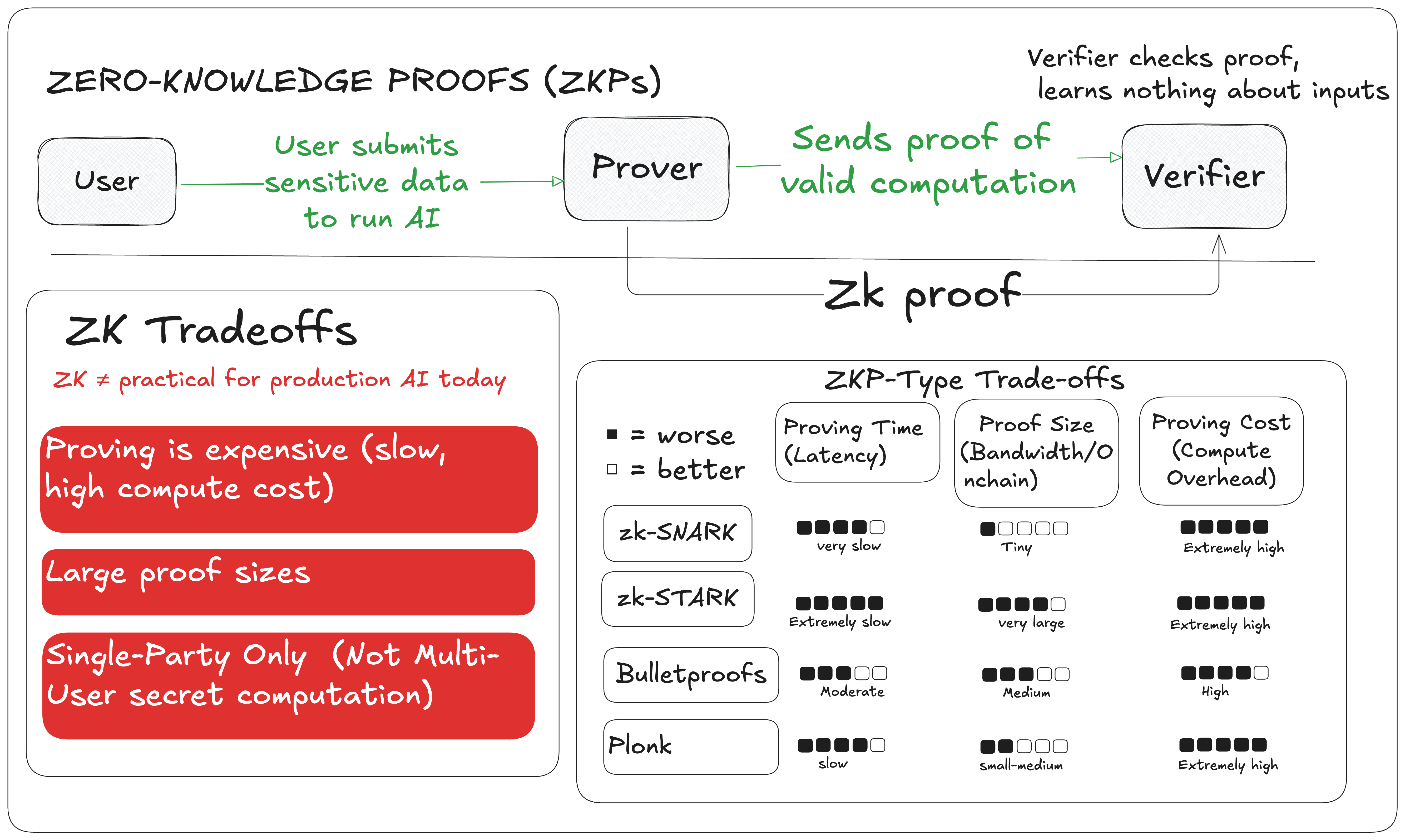

2. 零知识证明 (ZKP)

ZKP 让证明者可以证明计算是正确的,而无需在证明本身中泄露数据、模型或代码。在 AI (“ZK-ML”) 中,这意味着证明模型给出了正确的答案,而无需暴露输入或架构。

局限性:

-

深度模型的证明生成速度慢(数小时或数天)、资源密集,并且会生成大型证明,不适用于实时推理。

-

重要的是,ZK 仅隐藏证明中的数据;在证明生成期间(即在推理期间),服务器仍然可以看到所有输入和模型详细信息。

-

这种不匹配是为什么越来越多的趋势是在 TEE 内部运行 ZK 生成,将 ZK 的可验证性与 TEE 的运行时隐私相结合。

3. 全同态加密 (FHE)

FHE 允许你在加密数据上运行计算,因此永远不会出现明文。

它是最强的隐私形式,但速度极慢:通常比正常执行慢几十到几百倍,在某些情况下甚至更多,具体取决于模型和操作。

密文很大,并且非线性 AI 函数(如 ReLU 或 Softmax)需要解决方法。今天,它最适合安全聚合、搜索或批量推理,而不适合实时 AI。

4. 多方计算 (MPC)

MPC 让多个参与方可以一起计算,而无需相互泄露他们的输入。它提供强大的隐私,但通信量大,会增加延迟。

最适合参与者有限的小型、简单计算。通常与 TEE 或 ZKP 一起使用,以平衡速度和隐私。

混合未来:将 TEE 与 ZK 和其他工具相结合

隐私工具最好与 TEE 的快速、密封执行相结合,可以与密码学证明或多方协议配对,以创建高性能且可验证的系统。

-

例如,TEE 可以实时提供 AI 查询服务,然后输出一个 ZKP,证明它在正确的数据上运行了正确的代码。

-

TEE 还可以通过签署对其运行的代码和硬件的认证来充当可验证的预言机,这些认证可以发布在链上,供智能合约信任。

-

借助 NVIDIA 的 H100/H200 等 GPU TEE,即使模型训练也可以在 enclave 内在私有数据上进行,并添加 ZK 或 MPC 以实现选择性可审计性。

这些方法已经部署在生产中。在各个领域,保密计算正在从研究转向现实世界的基础设施,这使我们进入下一个问题:

谁在全球范围内使用保密 AI?

保密计算已经在企业环境和去中心化生态系统中大规模运行。

并且在几乎每个部署中,都有一个基础技术为其提供支持:TEE。

-

Microsoft (Azure Confidential Computing):为医疗保健、金融和政府部门的敏感工作负载运行 TEE 支持的 VM。用于安全地训练和部署私有数据上的 AI 模型。

-

NVIDIA:保密计算现在已直接内置于其 Hopper 和 Blackwell GPU 中,从而可以以最小的性能损失安全地运行大型模型。

-

Apple (Private Cloud Compute):保密 AI 的一个重要行业里程碑。PCC 通过将 iPhone 上的客户端 TEE 与 Apple Silicon 上的服务器端 TEE 相结合,即使在处理过程中也能保持用户输入和 AI 输出的加密状态。Apple 还在数据离开设备之前强制执行严格的屏蔽规则,确保仅发送必要的最低限度信息。该设计引起了广泛关注,其他手机制造商现在也正在采用类似的架构。

-

Amazon (AWS Nitro Enclaves):提供用于安全操作的隔离计算环境,现在用于测试保密 AI 推理和数据分析。

-

Fireblocks:将 TEE 与 MPC 相结合,以保护私钥并为机构数字资产启用安全交易签名。

谁在 Web3 中构建保密 AI?

计算网络:

-

Phala Network 提供去中心化的 GPU-TEE 云,将运行时隐私与 ZK/MPC 证明相结合,并且是第一个在安全 enclave 中对大规模 LLM 推理进行基准测试的公司。

-

Mind Network 为 AI 代理、加密 LLM 推理及其自己的 MindChain 区块链添加了基于 FHE 的保密计算层(Mind Network 正在与 Phala Network 合作)。

-

iExec 在 TEE 内部运行链下 AI,用于保护隐私的应用程序和 DePIN 协调,并提供 iApp Generator 等工具,以便于部署。

-

Oasis 提供 Sapphire(一个 TEE 支持的 EVM)和 ROFL(用于链下 AI 处理),为 WT3 等项目提供支持,WT3 是一种无需信任的 AI 交易机器人。

DeFi 和区块构建:

托管和密钥管理:

-

Clave 在 GPU TEE 中使用密码和生物识别登录保护钱包的安全,用于 AI 驱动的金融。

-

Fireblocks 将 TEE 和 MPC 结合在一起,以保护机构资产并启用基于保密 AI 的交易签名。

新兴参与者:

-

Super Protocol 正在创建一个去中心化的保密 AI 计算市场。PIN AI 专注于具有运行时保护的隐私至上的 AI 推理。

-

Fhenix 将 FHE 带到 Ethereum L2,用于保密合约和 AI 逻辑。

-

BasedAI 将 FHE 与零知识技术相结合,用于私有 LLM 推理。

在所有这些示例中,TEE 都在承担繁重的工作。它们的速度、硬件强制隔离以及 CPU 和 GPU 的广泛硬件支持使它们能够独特地处理生产中的敏感工作负载。

为什么 2025 年标志着保密 AI 的重大转变

在 2025 年,保密计算的采用已达到一个可衡量的转折点,这归因于 4 个核心发展:

-

市场规模:保密计算现在是一个价值 90 亿至 100 亿美元的产业,年增长率超过 60%。

-

风险投资:已向用于保护隐私的 AI 基础设施投资了超过 10 亿美元。

-

硬件可用性:NVIDIA (H100, Blackwell)、Intel (TDX) 和 AMD (SEV-SNP) 的处理器现在都带有内置的安全 enclave。这些已经用于在生产中运行具有 70B+ 参数的模型,性能开销不到 7%。

-

云支持:所有主要提供商,AWS、Azure、Google Cloud、Oracle、Alibaba、Tencent,都提供使用 TEE 的保密计算实例。

TEE 目前是唯一可以处理具有必要保密性和速度的实时 AI 工作负载的解决方案。其他密码学方法,如 ZKP、MPC 和 FHE,对于一般的低延迟任务来说太慢了。

但是,TEE 具有局限性:它们依赖于硬件供应商,并且需要额外的工具进行验证。因此,许多系统现在使用混合方法,将 TEE 的速度与密码学工具的正确性相结合。

虽然不是最终的解决方案,但在 2025 年,TEE 是保密 AI 最实用的基础。该行业现在正在努力将它们与密码学证明相结合,以提高透明度和信任度,而不会损失性能。

-

Hazeflow 是一家区块链研究公司,在研究、分析以及技术、产品和教育材料的创建方面拥有丰富的经验。

-

我们与难以清晰且有意义地解释其复杂产品的区块链团队(尤其是复杂技术团队)合作。

- 原文链接: research.hazeflow.xyz/p/...

- 登链社区 AI 助手,为大家转译优秀英文文章,如有翻译不通的地方,还请包涵~

- 网络匿名化内存池 174 浏览

- ZK编年史:哈希登场 161 浏览

- 区块链如何悄然保护你的在线购物体验 343 浏览

- Layer Zero 发布 Zero 链:去中心化的多核世界计算机 367 浏览

- “Jolt Inside” - 构建者需要了解的全新武器 290 浏览

- 以太坊的下一个重大转变:从重新执行每笔交易到验证 ZK 证明 381 浏览

- Zcash:比特币遗忘的隐私 436 浏览

- ZK编年史:计算模型 302 浏览

- lambdaworks 2026 年更新路线图和优先级 370 浏览

- 2026年构建机构级DeFi平台真正需要什么 913 浏览

- zkMesh:2026年1月回顾 457 浏览

- 如果它能编译,那它就是正确的(几乎):Lean 4 在 ZK 系统和工程中的介绍 654 浏览