第五章:智能的代价

- CountableMagic

- 发布于 2023-02-01 19:20

- 阅读 1216

本文介绍了通过零知识证明(ZKP)在区块链上进行机器学习推理的成本和性能研究,重点分析了不同ZKP系统在处理AI模型时的生成时间和内存使用情况,并探讨了相关应用场景。

*用温暖的英国口音* — “ 你能帮我把这个放在背景小声播吗?“?

嘿,你好,我们知道距离上次更新已经有一段时间了。请原谅我们在过去两个月的相对安静——别担心,我们带着充满蛋白质的章节回来了。如往常一样,我们的 Twitter 和 Discord 是获取最新信息的好地方。

缺少更新会让人更加渴望吗?

我们非常兴奋地与你分享我们的第一篇论文,由以太坊基金会资助: “ 智能的成本:用零知识证明机器学习推理”(或称为 paper0,酷孩子们是这么叫的)。

没错,真实的数据!图表!对理论构造及其对性能影响的讨论!这就是 全套 —— 实际上,paper0 是第一部针对共同的AI原语基准测试 ZK 证明系统的工作。而且,是的,你可以立即阅读它, 就在 这里 。

为此,请将本博客视为一篇伴随的文章(或者对于那些 逃课的 同学来说就是课堂读物),它总结了来自 paper0 的高阶要点。虽然我们努力确保论文的严谨性尊重我们引用的那些令人印象深刻的技术作品,但本博客将只是总结一些重要的内容。有关详细信息,请参考论文。

目前很有限……感谢你的推广,ChatGPT ;)

不再废话,让我们开始吧:

Paper0:我们的调查重点

自主性来了。实际上,计算的未来将涉及大量使用复杂的人工智能。看看我的文本编辑器:

Notion 的工具提示提醒我,他们的 LLM 会更好地完成这个句子

然而,链上并没有功能性的神经网络,连最小的推荐系统或匹配算法都没有。天哪!甚至连一个实验都没有…… 原因 ,当然,很明显——这实在是 太 贵 了。毕竟,运行数十万 FLOPs 的计算成本(几乎足够进行一次小神经网络的推理)是数百万的 gas,相当于数百美元。

那么如果我们想将 AI 范式引入无信任的世界,我们该怎么办?难道我们就会倒下不再爬起?当然不会……等一下!倒下…… 放弃 将…

如果像 Starkware、Matter Labs 和其他公司这样的 rollup 服务正在利用零知识证明大规模扩展计算,同时保持密码学安全性,我们能否对AI做同样的事情?

这个问题成为推动我们在 paper0 工作的动力萌芽。剧透一下,这就是我们发现的内容:

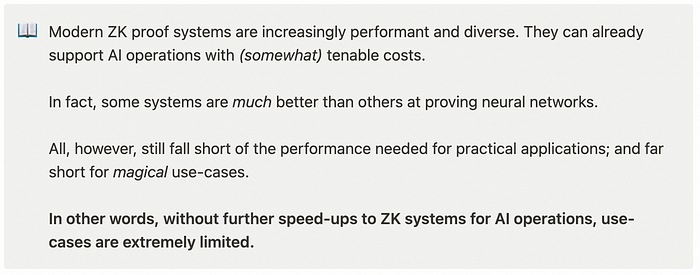

paper0 的要点

这里有一个 众所周知 的秘密:AI 性能几乎总是随着模型的大小而扩展。这一趋势似乎没有减缓的迹象。只要这种情况仍然存在,对我们这些处于 web3 的人来说,将尤其令人痛苦。

毕竟,计算成本是我们噩梦的终极、不可避免的来源。

今天的 ZKP 已经能够支持小模型。但中等到大型模型打破了这个范式

基准测试:实验设计

在 paper0 中,我们关注任何零知识证明系统中的两个基础指标:

- 证明生成时间: prover 创建与 AI 推理相关的证明所需的时间;

- 最高可用内存: Prover 在生成推理证明时的最大内存使用量,在证明的任意时刻

这主要是一个实践性的选择,也是我们在构建 Rockybot 时的经验(证明时间和内存使用直接决定了任何无信任 AI 用例的可行性)。此外,所有测量均以证明生成时间为参考,并未考虑预处理或见证生成。

当然,还有其他成本维度需要追踪。这包括验证者运行时间和证明大小。我们在以后可能会重新审视这些指标,但考虑这些超出了 paper0 的范围。

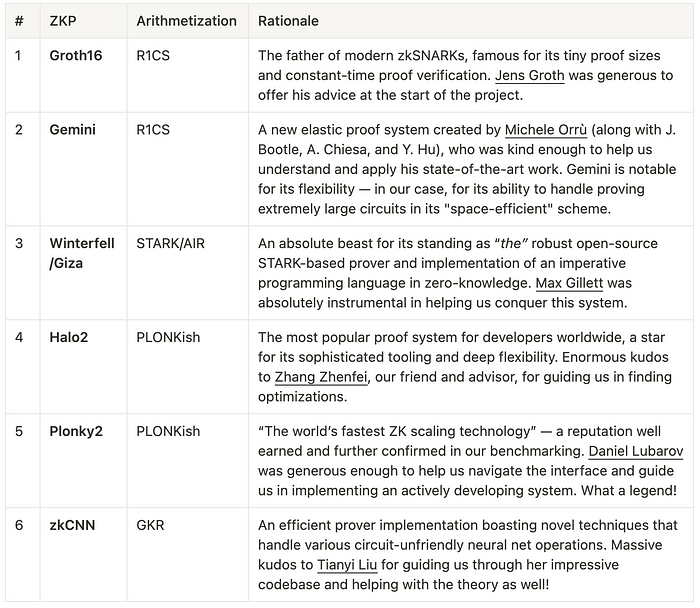

至于我们测试的实际证明系统,通过公众投票,我们选择了6种:

在 paper0 中测试的证明系统的总结表,以及协助我们的作者

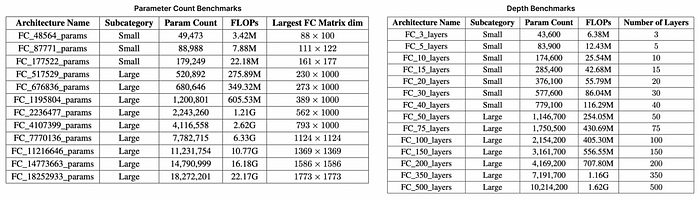

最后,我们创建了两个 多线性感知器 (MLP) 套件进行基准测试——值得注意的是,MLP 是相对简单的,主要由线性操作构成,与更复杂的架构相同且相似。这包括一个随着参数数量增加(最多 1800 万个参数和 22 GFLOPs)而扩展的架构套件,以及一个随着层数增加(最多 500 层)而扩展的第二套架构。每个套件,如下表所示,测试了证明系统的不同扩展能力,并大致代表了知名的深度学习架构的规模,从 LeNet5(60k 参数,0.5 MFLOPs)到 ResNet-34(2200 万个参数,3.77 GFLOPs)。

参数和深度的基准测试套件

结果:飞快而猛烈

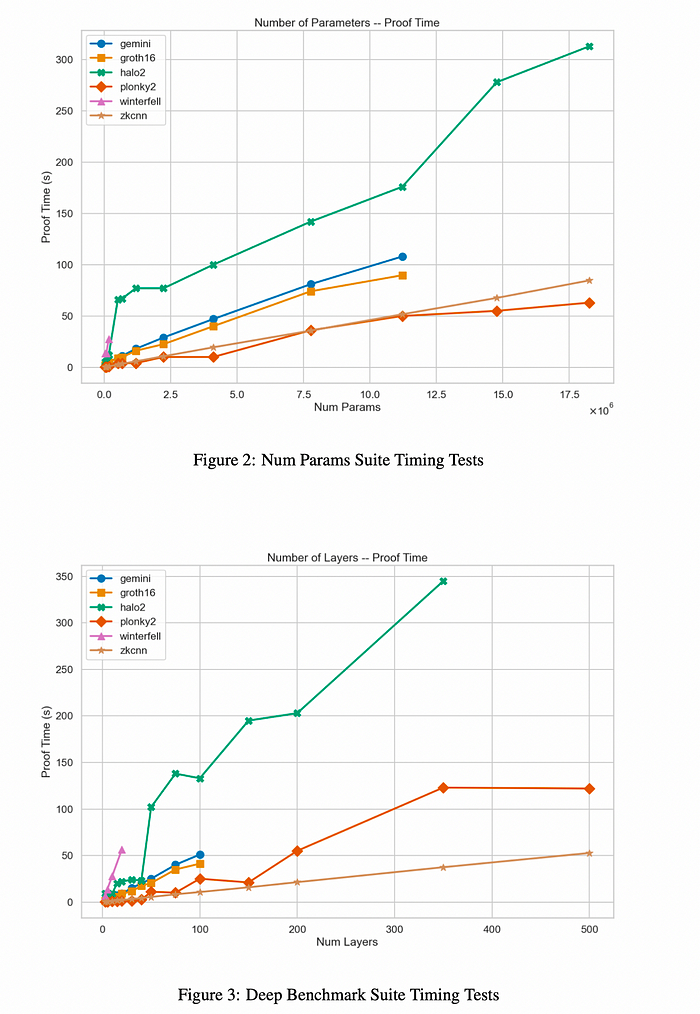

在所有 6 种证明系统中,参数和深度规模的证明生成时间结果

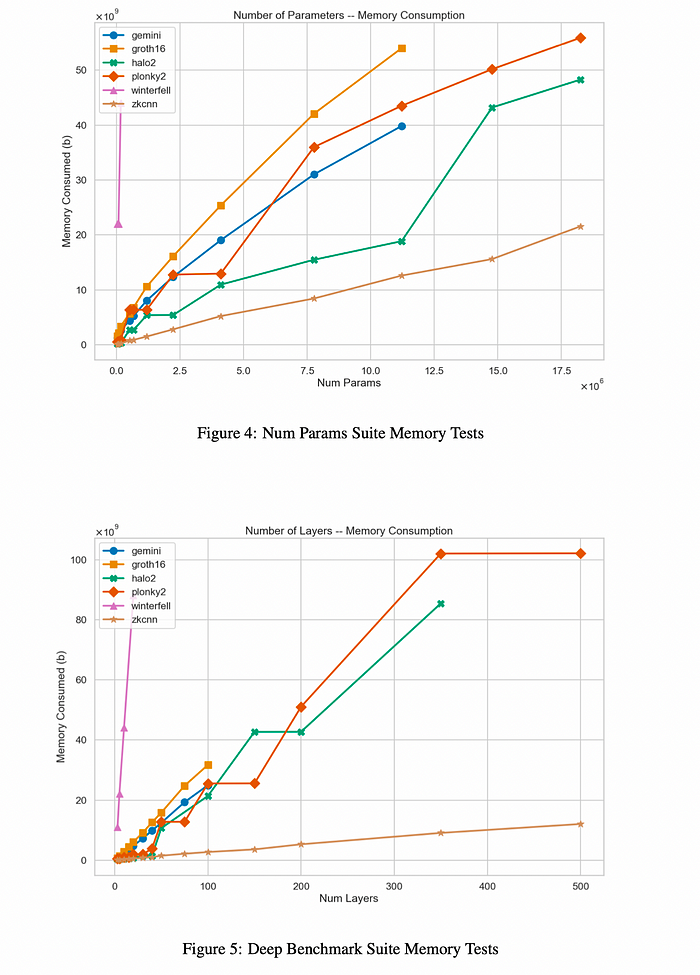

在所有 6 种证明系统中,参数和深度规模的峰值内存结果

有关这些结果的完整细分,以及对各个系统瓶颈的深入分析,请参见 paper0 的第 4 节。

应用场景和主要收获

好的,这些图表真不错,但这实际上在实践中意味着什么?我们将重点介绍两个例子:

1. Worldcoin—— Worldcoin 正在构建世界上第一个 “隐私保护证明身份协议”(或者说 PPPoPP,如果你斯文一点的话)。换句话说,通过将身份验证与一种独特的生物特征 —— 虹膜相结合,解决 Sybil 攻击。

这是… 一个疯狂的想法,其中使用Rollup神经网络来压缩、转换和证明存储的虹膜数据。虽然他们目前的设置在球体硬件中涉及一个可信计算环境,但他们希望使用 ZKP 来证明模型的正确计算。这也将允许用户以加密安全保证自我保管自己的生物特征数据(只要在用户的硬件上处理——比如他们的手机)。

现在说得具体一点:Worldcoin 的模型具有180万的参数和50层。这是区分 100 亿不同虹膜所需的模型复杂性。哎呀!

虽然像 Plonky2 这样的证明系统可以在计算优化的云 CPU 上在短短 几分钟内 为这种大小的模型生成推理证明,但 prover 的内存消耗会超出任何商业上可用的移动硬件( 数十 GB 的 RAM)。

事实是,没有哪个 tested 系统能在移动硬件上证明这个神经网络…

2. AI Arena—— AI Arena 是一个链上平台战斗游戏,风格借鉴了《超级粉碎兄弟》,并带有独特的曲折:玩家 拥有 的 AI 模型相互竞争并自主战斗,而不是玩家 操作 的化身实时对抗彼此。是的,这听起来和 一样酷。

随着时间的推移,AI Arena 的精彩团队正在努力将他们的游戏移至一个完全无信任的赛事机制。问题是,这涉及到验证每场游戏中惊人的大量 AI 计算的挑战。

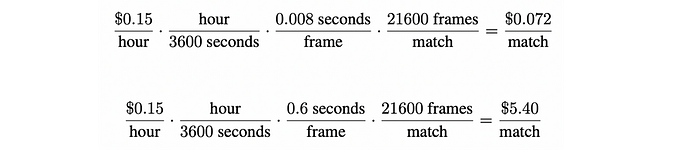

比赛以每秒 60 帧的速度进行,持续 3 分钟。这意味着每轮两个玩家模型之间超过 20,000 个推理结果。以 AI Arena 的一个策略网络为例 —— 一个相对较小的 MLP,进行一次前向传递大约需要 ∼ 0.008 秒——使用 zkCNN 证明这个模型需要 0.6 秒,也就是说在每个动作中约增加 1,000 倍的计算。

这也意味着 计算成本增加了 1,000 倍。随着单元经济学对链上服务变得越来越重要,开发者必须在去中心化安全的价值与证明生成的实际成本之间取得平衡。

https://aws.amazon.com/ec2/pricing/

无论是上述例子、ZK-KYC、DALL-E 风格的图像生成,还是甚至智能合约中的大型语言模型,在 ZKML 的世界中存在着整个用例宇宙。要实现这些,我们深信 ZK 证明器仍需要大幅改进。尤其是为了实现 自我改进区块链的未来。

那么接下来我们该往哪里走呢?

我们有了具体的性能数字。我们知道在证明神经网络时那些技术通常表现最佳。当然,我们开始发现哪些用例既能激励又能激发我们日益壮大的社区。

我想知道接下来会发生什么……

更多的更新很快就会到来 ;)

感谢我们的好脾气:致谢

我们知道,在期刊准备的过程中,社区中的很多人对我们表现出了极大的耐心——感谢你在整个过程中给予的持续支持! 你值得一篇经过深入研究、细致整理和审查的优秀作品,因此我们付出了努力确保达到这个标准。

但当然,我们并不是独自走到这一步的;人们说,村庄的力量不可或缺。然而,他们从未提到优化电路的那部分……因此,鉴于这并不是多么详尽的名单,我们必须特别感谢以下人士:

- 我们的世界级顾问和导师: Zhang Zhenfei, Riad Wahby, 和 Rand Hindi

- 以太坊基金会, 感谢他们资助我们的研究

- 还有,感谢他们的反馈和批评: Jens Groth, Daniel Lubarov, Tianyi Liu, Max Gillett, Michele Orrú, Yi Sun, Kobi Gurkan, Luke Pearson, Nima Vaziri, Jonatan Luther-Bergquist, dcbuilder, Brandon Da Silva, 和 guiltygyoza

谢谢,谢谢,谢谢!

今天的内容到此为止!

- 原文链接: medium.com/@CountableMag...

- 登链社区 AI 助手,为大家转译优秀英文文章,如有翻译不通的地方,在这里修改,还请包涵~

- 2025年第四季度加密货币和区块链风险投资 68 浏览

- lambdaworks 2026 年更新路线图和优先级 57 浏览

- REVM源码阅读-Context 107 浏览

- 2026年构建机构级DeFi平台真正需要什么 178 浏览

- zkMesh:2026年1月回顾 197 浏览

- 如果它能编译,那它就是正确的(几乎):Lean 4 在 ZK 系统和工程中的介绍 221 浏览

- Zcash 的时代到来了 259 浏览

- 代币化的真实世界资产:初学者须知 421 浏览

- 量子计算与区块链:匹配紧迫性与实际威胁 434 浏览

- ZK 编年史:电路(第二部分) 292 浏览

- 房产代币化的分步指南 372 浏览

- Vitalik: 2026年我对使用的软件做了两个重大改变 366 浏览