AI安全:保护模型免受威胁与攻击

- dave-patten

- 发布于 2025-02-13 16:44

- 阅读 4025

本文探讨了AI模型在从训练到部署的整个生命周期中面临的各种安全威胁,并提出了对抗这些威胁的最佳实践和模块化安全框架。文章详细介绍了针对大型语言模型(LLM)、对抗性攻击、数据中毒、模型提取等特定威胁的防御策略,并提供了实用的安全清单。

人工智能(AI)模型正在革命化各个行业,从网络安全和医疗保健到金融和自动化。然而,它们也成为对抗性攻击、数据污染和推理威胁的主要目标。攻击者可以操纵AI系统,提取敏感数据,甚至降低模型性能,导致安全漏洞和不可靠的输出。

本文探讨了从训练到部署保护AI管道的最佳实践,包括:

- LLM特定威胁(例如,提示注入、内存攻击)

- 对抗风险(例如,规避、模型提取)

- AI模型的CI/CD管道强化

- 实时部署监控

- 大型语言模型的OWASP前10大风险

到最后,你将拥有一个实用的安全AI检查清单和一条加强你的AI模型以抵御不断演变的威胁的路线图。

🚀这篇文章是我AI安全与开发系列的一部分,在这里我探讨塑造2025年AI的最佳实践、风险和技术。该系列基于我在云架构与DevOps以及区块链与Web3方面的前期工作,我涵盖了可扩展基础设施、安全模型和去中心化技术。AI正在快速发展,安全、部署和Web3集成比以往任何时候都更加重要。

🔹如果你对AI安全及其与云和区块链的交集感兴趣,请务必关注我以获取更深入的见解!

AI安全日益严峻的威胁格局

随着AI模型在业务运营中变得不可或缺,相关的风险也随之增加。攻击者利用管道每个阶段的脆弱性:

- 对抗性攻击:操纵输入欺骗模型进行错误分类。

- 数据污染:在训练过程中注入恶意数据,改变模型行为。

- 模型提取:逆向工程输出以重建专有AI模型。

- 推理攻击:利用API调用提取敏感的训练数据。

- 提示注入(LLMs):操纵生成模型绕过安全过滤器。

- 供应链攻击:在AI开发管道中注入脆弱性。

如果没有强大的AI安全实践,攻击者可以操纵AI预测,提取私人数据或向模型注入恶意指令。保护AI管道至关重要。

为了对抗这些威胁,我们需要一个模块化且全面的安全框架,集成到AI管道中。

OWASP针对LLM应用的前10大保障措施提供了一种结构化的方式来缓解特定于LLM的威胁,例如提示注入(LLM01)、数据泄露(LLM02)和供应链脆弱性(LLM08)。

模块化AI安全框架

采用结构化方法确保AI模型在其生命周期中保持安全。以下是设计用于独立执行或整合到统一管道中的关键安全模块,每个模块旨在减轻特定攻击向量,同时集成入DevSecOps管道。

1. 静态模型分析:检测恶意负载

AI模型通常以Pickle (.pkl)或HDF5 (.h5)格式序列化,可能会受到恶意负载或后门注入的侵害。攻击者可以在这些文件中嵌入脚本,使其在加载时允许远程代码执行。通过使用Protect AI的ModelScan,团队可以分析序列化模型工件,寻找不安全的反序列化模式,检测嵌入的恶意软件,并在部署前验证文件的完整性。

攻击向量:

- 负载注入(OWASP LLM04:不安全的输出处理):在模型序列化文件中嵌入有害脚本。

- 后门攻击:恶意训练的触发器影响预测。

安全措施:

- 扫描AI模型文件以检测嵌入的恶意软件。

- 验证序列化格式,如Pickle和H5,以检测完整性违规。

2. 对抗性稳健性测试:增强模型抵抗攻击能力

对抗性攻击利用微小、通常不可感知的输入变化来欺骗AI模型做出错误预测。攻击者还可能向训练集注入恶意数据,导致模型表现异常。通过使用对抗性稳健性工具包(ART),团队可以模拟对抗攻击场景,识别脆弱性,并实施防御性训练策略。

攻击向量:

- 规避攻击(OWASP LLM05:模型盗取):操纵输入以欺骗AI。

- 污染攻击(OWASP LLM06:训练数据污染):损坏训练数据集。

- 模型提取:通过API响应逆向工程AI模型。

安全措施:

- 模拟对抗性攻击以揭示弱点。

- 实施稳健的训练技术以减轻数据污染。

3. LLM特定安全性:保护生成性AI

大型语言模型(LLMs)如GPT和BERT容易受到提示注入、数据泄露和内存攻击。攻击者可以操纵提示来绕过安全机制、提取训练数据或利用缓存的内存状态。NVIDIA Garak提供LLM的安全测试,检测有害的提示模式并防止基于输出的数据泄露。它确保模型在处理输入时安全,不会无意中暴露敏感数据。

攻击向量:

- 提示注入(OWASP LLM01):操纵提示以绕过过滤器。

- 内存攻击(OWASP LLM03:不安全的插件设计):提取缓存的敏感数据。

- 数据泄露(OWASP LLM02):从模型响应重建私人训练数据。

安全措施:

- 使用过滤层检测可疑的提示操纵。

- 实施内存安全执行以防止用户数据泄露。

4. NLP模型安全:测试对抗抵抗能力

用于聊天机器人、情感分析和文档分类的NLP模型特别容易受到基于文本的对抗性攻击。攻击者利用拼写错误、同义词替换和改写技术来操纵输出。TextAttack允许团队在对抗条件下评估NLP模型,确保模型在语言操控和偏见利用方面保持稳健。

攻击向量:

- 文本对抗攻击:拼写错误、同义词替换和改写导致NLP模型误导。

- 偏见利用(OWASP LLM07):操纵训练数据中的偏见以生成有害输出。

安全措施:

- 对NLP系统进行对抗性稳健性测试。

- 使用自动化数据扩增技术提高模型的抵抗力。

5. 多模态稳健性测试:保护跨模态AI模型

AI模型越来越多地处理多种数据类型 - 文本、图像、音频和视频 - 使其易受跨模态对抗攻击的威胁。攻击者可以在图像中引入细微扭曲或操控音频波形,以改变模型输出而不触发安全警报。AugLy提供多模态稳健性测试,帮助AI工程师评估跨模态交互并检测对抗性扰动。

攻击向量:

- 输入扰动:图像或音频中的微小扭曲以改变模型输出。

- 跨模态利用:针对不同数据类型之间的交互。

安全措施:

- 验证模型对多格式对抗攻击的稳健性。

- 实施预处理技术以减轻扭曲。

6. 供应链完整性:保护AI开发管道

AI模型的安全性仅与其开发管道一样强。攻击者以CI/CD工作流为目标,向AI部署中注入被破解的依赖项或篡改的工件。使用AIShield Watchtower,团队可以追踪AI模型的来源,监控数据集的完整性,并检测管道操作。

攻击向量:

- 管道污染(OWASP LLM08:供应链脆弱性):在AI管道中注入后门。

- 工件替换:用被破坏的版本替换受信任的模型。

安全措施:

- 在输入前监控和验证数据集的完整性。

- 对生产管道中的模型工件进行加密签名。

7. 部署监控:实时威胁检测

即使在模型部署后,攻击者仍可能尝试实时推理攻击,以操控预测或提取敏感信息。HiddenLayer Model Scanner提供AI推理端点的持续安全监控,检测异常行为、未经授权的访问和可疑的API调用。

攻击向量:

- 推理时间攻击:制作输入以操控预测。

- 端点利用(OWASP LLM09):利用AI API进行恶意意图。

安全措施:

- 实施对AI API的实时监控。

- 设置异常检测警报以发现恶意活动。

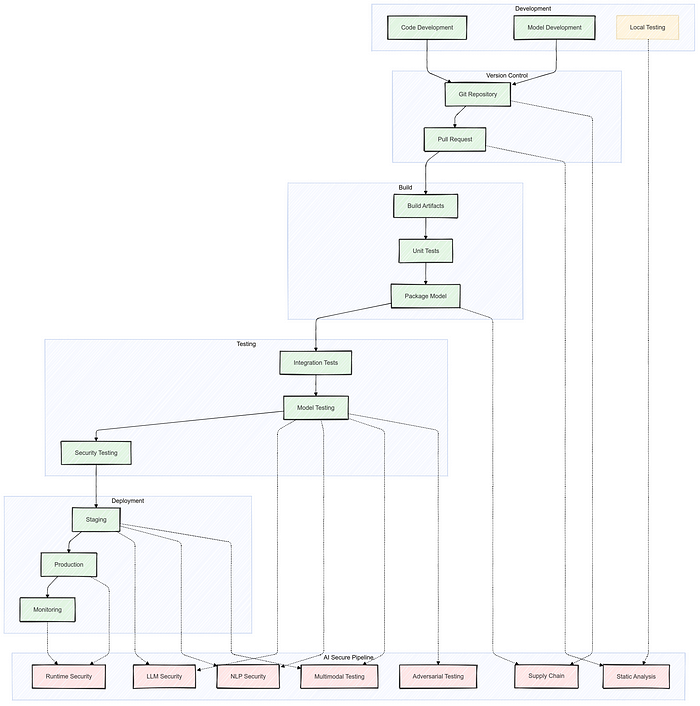

DevSecOps集成:CI/CD中的AI安全

将AI安全集成到DevSecOps管道中,确保从开发到生产的持续有效性。以下关键管道阶段将AI安全嵌入到CI/CD工作流中:

https://github.com/empires-security/aisp

1️⃣ 开发:通过静态分析进行早期安全验证。

2️⃣ 版本控制:在GitHub/GitLab中进行自动安全检查。

3️⃣ 构建阶段:工件扫描和依赖验证。

4️⃣ 测试:对LLM、NLP和多模态AI进行对抗性测试。

5️⃣ 部署:运行时监控和异常检测。

安全AI检查清单

此检查清单提供结构化的方法,以保护AI模型从开发到部署,结合OWASP AI安全原则及LLM、对抗防御和供应链完整性的最佳实践。

开发与模型训练

从一开始就用主动防御保护你的AI模型。

- 对AI模型文件进行静态分析,以检测不安全的反序列化、后门或恶意负载(OWASP LLM04)。

- 使用对抗性稳健性测试工具(例如,对抗性稳健性工具包、CleverHans)评估模型对规避和污染攻击的抵抗能力(LLM05,LLM06)。

- 通过实施差分隐私、数据来源追踪和数据集验证来保护训练数据,以防止污染攻击(LLM06)。

- 通过对数据集进行哈希、为AI模型版本控制,以及采用可审计的管道确保模型可重现性。

- 在可能的情况下使用联邦学习或合成数据以最小化数据暴露。

- 最小化敏感数据的保留,以防止数据泄露攻击(LLM02)。

部署与推理安全

保护AI模型免受实时威胁和未经授权的访问。

- 使用输入清理、指令解析和提示过滤工具(例如,NVIDIA Garak)保护LLM免受提示注入(OWASP LLM01)的影响。

- 实时监控AI推理端点,查找异常、未经授权的访问和恶意查询(LLM09)。

- 使用访问控制和API速率限制限制查询频率,防止模型提取或滥用。

- 在API响应中实施加密和差分隐私,以最小化数据泄露风险(LLM02)。

- 部署强健的身份验证(OAuth2、JWT、API密钥)以防止未经授权使用AI模型。

- 启用日志记录和审计跟踪,以追踪和审查API交互,防止潜在的推理攻击。

- 确保LLM的内存安全,以防止状态持续性攻击(LLM03)。

DevSecOps与CI/CD增强

将AI安全集成到DevSecOps管道中,以维护供应链完整性。

- 实施供应链完整性检查(LLM08),以检测篡改的依赖项、被破坏的AI模型和污染的数据集。

- 在版本控制中自动化安全扫描(例如,GitHub Actions、SonarQube、Jenkins)。

- 对AI模型使用加密签名和哈希验证,以防止工件替换攻击。

- 使用工具如AIShield Watchtower扫描AI模型依赖项以发现漏洞。

- 强制执行最低权限访问,以尽量减少AI权重和敏感模型的暴露。

- 在生产环境中启用实时异常检测(例如,HiddenLayer Model Scanner)。

- 周期性地使用对抗性稳健性增强对模型进行重训练,以减轻演变的威胁。

- 使用持续监控工具(例如,Prometheus、Grafana)跟踪AI系统性能和安全事件。

结论

AI安全不仅仅是一种关注,而是必要性。随着对抗性攻击和模型利用快速演变,加强从训练到部署的AI管道至关重要。通过集成静态分析、对抗性测试、供应链监控和实时保护,你可以加强AI模型,抵御新兴威胁。

💡 下一步:

- 在你的AI工作流程中实施安全AI检查清单。

- 探索像ART、NVIDIA Garak和HiddenLayer这样的工具,进行AI安全测试。

- 分享你的想法,你如何保护自己的AI模型?让我们在评论中讨论!🚀

~~

这篇文章是我AI安全与开发系列的一部分,在这里我分析AI、Web3和云中的前沿安全挑战。如果你对这个主题感兴趣,请务必查看我之前的系列,有关云架构与DevOps以及区块链与Web3的更深入见解。

- 下一篇文章:对抗性AI与模型强化:对抗攻击的防御

- 原文链接: medium.com/@dave-patten/...

- 登链社区 AI 助手,为大家转译优秀英文文章,如有翻译不通的地方,还请包涵~

- 欺诈与生成式人工智能和代理人工智能的兴起 115 浏览

- 关于伊朗监控影响的好文章 182 浏览

- “夺旗”竞赛继续! 318 浏览

- 智能合约代理模式:2026 年安全指南 495 浏览

- zkMesh:2026年1月回顾 462 浏览

- 每个开发者都应该知道的Go高级技巧 (Go并发性能和最佳实践) 488 浏览

- 我们如何确定Web3团队采用AI审计的投资回报率? 415 浏览

- Eloizer 介绍:Solana 程序的静态分析器 - Inversive Labs 463 浏览

- 使用 Move Prover 验证 Aptos Vault 的正确性 459 浏览

- 守护增长 - Certora 在 2025 年如何保障 DeFi 安全 668 浏览

- 深入分析:Truebit 事件博客 776 浏览

- Certora CTF 解题报告 214 浏览